Kullback-Leibler-Information

- Kullback-Leibler-Information

-

Die Begriffe Kullback-Leibler-Divergenz (kurz KL-Divergenz), Kullback-Leibler-Entropie, Kullback-Leibler-Information oder Kullback-Leibler-Abstand (nach Solomon Kullback und Richard Leibler) bezeichnen ein Maß für die Unterschiedlichkeit zweier Wahrscheinlichkeitsverteilungen desselben Ereignishorizonts. Typischerweise repräsentiert P Beobachtungen oder eine präzise Wahrscheinlichkeitsverteilung, während Q ein Modell oder eine Approximation darstellt.

Vorsicht: Die KL-Divergenz wird auch relative Entropie genannt, wobei der Begriff relative Entropie gelegentlich auch für die Transinformation verwendet wird.

Formal lässt sich die KL-Divergenz für die Wahrscheinlichkeitsfunktionen P und Q diskreter Werte folgendermaßen bestimmen:

.

.

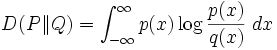

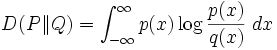

Werden die Verteilungen P und Q für kontinuierliche Werte durch die Wahrscheinlichkeitsdichtefunktionen p und q dargestellt, wird hingegen ein Integral berechnet:

Die Kullback-Leibler-Divergenz gibt aus informationstheoretischer Sicht an, wieviele Bits durchschnittlich verschwendet werden, wenn eine eigentlich auf q basierende Kodierung auf Ereignisse angewendet wird, die p folgen. Somit besteht ein Zusammenhang zur Kanalkapazität.

Anstatt der Kullback-Leibler-Divergenz wird auch oft die Kreuzentropie verwendet. Diese liefert qualitativ vergleichbare Werte, kann jedoch ohne die Kenntnis von p berechnet werden. In praktischen Anwendungen ist dies vorteilhaft, da dort p meist unbekannt ist.

Belege

- S. Kullback, R. A. Leibler: On information and sufficiency. In: Annals of Mathematical Statistics. 22, Nr. 1, März 1951, S. 79–86.

- S. Kullback; John Wiley & Sons (Hrsg.): Information theory and statistics. 1959.

- Springer Online Reference Works. eom.springer.de. Abgerufen am 31. März 2008. (englisch)

Wikimedia Foundation.

:

Schlagen Sie auch in anderen Wörterbüchern nach:

Kullback–Leibler divergence — In probability theory and information theory, the Kullback–Leibler divergence[1][2][3] (also information divergence, information gain, relative entropy, or KLIC) is a non symmetric measure of the difference between two probability distributions P … Wikipedia

Kullback-Leibler-Abstand — Die Begriffe Kullback Leibler Divergenz (kurz KL Divergenz), Kullback Leibler Entropie, Kullback Leibler Information oder Kullback Leibler Abstand (nach Solomon Kullback und Richard Leibler) bezeichnen ein Maß für die Unterschiedlichkeit zweier… … Deutsch Wikipedia

Kullback-Leibler-Distanz — Die Begriffe Kullback Leibler Divergenz (kurz KL Divergenz), Kullback Leibler Entropie, Kullback Leibler Information oder Kullback Leibler Abstand (nach Solomon Kullback und Richard Leibler) bezeichnen ein Maß für die Unterschiedlichkeit zweier… … Deutsch Wikipedia

Kullback-Leibler-Entropie — Die Begriffe Kullback Leibler Divergenz (kurz KL Divergenz), Kullback Leibler Entropie, Kullback Leibler Information oder Kullback Leibler Abstand (nach Solomon Kullback und Richard Leibler) bezeichnen ein Maß für die Unterschiedlichkeit zweier… … Deutsch Wikipedia

Kullback-Leibler-Divergenz — Die Begriffe Kullback Leibler Divergenz (kurz KL Divergenz), Kullback Leibler Entropie, Kullback Leibler Information oder Kullback Leibler Abstand (nach Solomon Kullback und Richard Leibler) bezeichnen ein Maß für die Unterschiedlichkeit zweier… … Deutsch Wikipedia

Divergence de Kullback-Leibler — En théorie des probabilités et en théorie de l information, la divergence de Kullback Leibler[1], [2] (ou divergence K L ou encore entropie relative) est une mesure de dissimilarité entre deux distributions de probabilités P et Q. Elle doit son… … Wikipédia en Français

Divergence De Kullback-Leibler — En théorie des probabilités et en théorie de l information, la divergence de Kullback Leibler[1] [2] (ou divergence K L ou encore Entropie relative) est une mesure de dissimilarité entre deux distributions de probabilités P et Q. Elle doit son… … Wikipédia en Français

Divergence de kullback-leibler — En théorie des probabilités et en théorie de l information, la divergence de Kullback Leibler[1] [2] (ou divergence K L ou encore Entropie relative) est une mesure de dissimilarité entre deux distributions de probabilités P et Q. Elle doit son… … Wikipédia en Français

Information Mutuelle — Dans la théorie des probabilités et la théorie de l information, l information mutuelle de deux variables aléatoires est une quantité mesurant la dépendance statistique de ces variables. Elle se mesure souvent en bit. L information mutuelle d un… … Wikipédia en Français

Information theory — Not to be confused with Information science. Information theory is a branch of applied mathematics and electrical engineering involving the quantification of information. Information theory was developed by Claude E. Shannon to find fundamental… … Wikipedia

.

.