- Cascade Correlation

-

Cascade Correlation ist ein mathematisches konstruktives Verfahren zur Erzeugung und zum Training von künstlichen neuronalen Netzen. Veröffentlicht wurde Cascade Correlation 1990 von Scott E. Fahlman und Christian Lebiere in der Arbeit "The Cascade-Correlation Learning Architecture".

Die Idee hinter Cascade Correlation ist nicht nur das Training eines neuronalen Netzes, sondern auch der Aufbau dessen Struktur (konstruktives Verfahren). Der große Vorteil dabei ist, dass sich das neuronale Netzwerk in seiner Größe an die Problemstellung (Trainingsdaten) anpasst.

Der Algorithmus startet mit einem, für die Aufgabenstellung, minimalen neuronalen Netz, das nur aus Eingabezellen und Ausgabezellen besteht. Die Neuronen sind dabei über Gewichte vollständig miteinander verbunden. Das Training der Gewichte erfolgt nun mit Hilfe eines Lernverfahrens (Quickprop). Wird über mehrere Trainingsepochen keine signifikante Verbesserung des Netzwerkfehlers mehr erreicht, wird das Training beendet. Die gefundenen Gewichte werden beibehalten und ein neues (verdecktes) Neuron wird zum Netzwerk hinzugefügt. Das verdeckte Neuron (Candidate Unit) erhält als Eingänge Verbindungen von allen Eingabezellen und eventuell zuvor hinzugefügten verdeckten Zellen. Der Ausgang des zugefügten Neurons hat vorerst keine Verbindung zum Netzwerk. Es erfolgt nun das Training für die Gewichte des neuen Neurons. Ziel des Trainings ist es, Sj ,die Summe der Beträge der Kovarianz zwischen oj, der Ausgabe der Candidate Unit, und δk, dem Restfehler der Ausgabezelle k, über alle Ausgabezellen zu maximieren.

Hierbei ist j der Index der Candidate Unit, k der Laufindex über alle Ausgangsneuronen, p der Index der Muster,

die mittlere Ausgabe von Neuron j über alle Muster p und

die mittlere Ausgabe von Neuron j über alle Muster p und  der mittlere Fehler der Ausgabezellen k über alle Muster p. Der Fehler δk ist gegeben durch die Differenz zwischen erwünschten Ausgang und dem tatsächlichen Ausgang. Ziel ist es, Sj zu maximieren. Daher muss die partielle Ableitung von Sj nach jedem Gewicht wij der Zelle gebildet werden.

der mittlere Fehler der Ausgabezellen k über alle Muster p. Der Fehler δk ist gegeben durch die Differenz zwischen erwünschten Ausgang und dem tatsächlichen Ausgang. Ziel ist es, Sj zu maximieren. Daher muss die partielle Ableitung von Sj nach jedem Gewicht wij der Zelle gebildet werden.

Mit der Definition:

![\sigma_{k} = sgn \left[ \sum_{p}(o_{pj} - \bar o_{j}) \, (\delta_{pk} - \bar \delta_{k}) \right]](1/ce114f51e5a00869442cded4e69748e9.png)

und

Ist die partielle Ableitung zu jedem Gewicht der Candidate Unit bestimmt, kann ein Gradientenaufstieg durchgeführt werden. Das Training wird so lange fortgesetzt, bis keine wesentliche Veränderung von Sj mehr erfolgt. Der Ausgang des zugefügten Neurons liefert nun ein maximales Ausgangssignal, wenn der Fehler des restlichen Netzwerkes am größten ist. Die Gewichte der Candidate Unit werden jetzt permanent eingefroren und der Ausgang der Zelle vollständig mit jedem vorhandenen Ausgangsneuronen verbunden. Ein neues Training der Gewichte aller Ausgangsneuronen wird nun gestartet. Ist nach dem Training der gewünschte Ausgangsfehler noch nicht erreicht, wird, wie oben beschrieben, ein weiteres verdecktes Neuron dem Netzwerk zugeführt und trainiert.

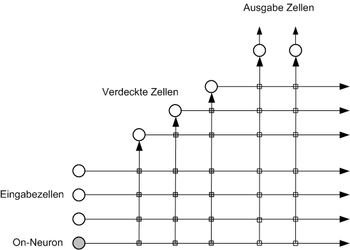

Das Bild unten zeigt ein Cascade Correlation Netzwerk mit drei verdeckten Neuronen. Die Gewichte sind hierbei als Quadrate auf den Verbindungsstellen zwischen Ausgängen und Eingängen der Neuronen dargestellt. Das on-Neuron dient für alle Neuronen des Netzwerkes zur Einstellung der Ansprechschwelle; es besitzt als Ausgabe immer den Wert 1.

Beim Cascade Correlation Algorithmus werden verdeckte Zellen nur einmal trainiert und die gefundenen Gewichte nicht mehr verändert, während die Gewichte für die Ausgangsneuronen in jedem Schritt neu angepasst werden.

Das Verfahren konvergiert verhältnismäßig gut, da immer nur eine Schicht des Netzwerks trainiert wird. Damit vermeidet man das Problem bei komplexen Netzwerken, dass sich gleichzeitig alle Neuronen durch ein Training auf ein gegebenes Eingangsmuster anpassen, während sie nur mit lokale Informationen über den zurückpropagierten Fehler über die direkten Nachbaren versorgt werden.

Literatur

- Scott E. Fahlman und Christian Lebiere: The Cascade-Correlation Learning Architecture, 29. August 1991

Wikimedia Foundation.