- Bayes-Normalverteilungsklassifikator

-

Ein Bayes-Klassifikator (Aussprache: [ˈbeiz], benannt nach dem englischen Mathematiker Thomas Bayes) ist ein aus dem Bayestheorem hergeleiteter Klassifikator. Er ordnet jedes Objekt der Klasse zu, zu der es mit der größten Wahrscheinlichkeit gehört, oder bei der durch die Einordnung die wenigsten Kosten entstehen. Genau genommen handelt es sich um eine mathematische Funktion, die jedem Punkt eines Merkmalsraums eine Klasse zuordnet.

Um den Bayes-Klassifikator zu definieren, wird ein Kostenmaß benötigt, das jeder möglichen Klassifizierung Kosten zuweist. Der Bayes-Klassifikator ist genau derjenige Klassifikator, der die durch alle Klassifizierungen entstehenden Kosten minimiert. Das Kostenmaß wird gelegentlich auch Risikofunktion genannt; man sagt dann, der Bayes-Klassifikator minimiere das Risiko einer Fehlentscheidung und sei über das minimum-risk-Kriterium definiert.

Wird ein primitives Kostenmaß verwendet, das ausschließlich bei Fehlentscheidungen Kosten verursacht, so minimiert der Bayes-Klassifikator die Wahrscheinlichkeit einer Fehlentscheidung. Man sagt dann, er sei über das maximum-a-posteriori-Kriterium definiert.

Beide Formen setzen voraus, dass die Wahrscheinlichkeit, dass ein Punkt des Merkmalsraums zu einer bestimmten Klasse gehört, bekannt ist, jede Klasse also durch eine Wahrscheinlichkeitsdichte beschrieben wird. In der Realität sind diese Dichtefunktionen aber nicht bekannt; man muss sie abschätzen. Dazu vermutet man hinter jeder Klasse einen Typ von Wahrscheinlichkeitsverteilung - in der Regel eine Normalverteilung - und versucht anhand der vorhandenen Daten, deren Parameter abzuschätzen.

Weit häufiger wird der Bayes-Klassifikator jedoch zur Beurteilung anderer Klassifikatoren verwendet: Man entwirft künstlich einige Klassen und deren Wahrscheinlichkeitsdichten, erzeugt mit diesem Modell eine zufällige Stichprobe und lässt den anderen Klassifikator die Objekte dieser Stichprobe in Klassen einteilen. Das Ergebnis vergleicht man mit der Einordnung, die der Bayes-Klassifikator vorgenommen hätte. Da der Bayes-Klassifikator in diesem Fall optimal ist, erhält man eine Abschätzung, wie nahe der andere Klassifikator am Optimum liegt. Gleichzeitig liefert der Bayes-Klassifikator eine untere Schranke für die Fehlerwahrscheinlichkeit aller anderen Klassifikatoren in diesem Szenario; besser als der optimale Bayes-Klassifikator können diese nicht werden.

Inhaltsverzeichnis

Naiver Bayes-Klassifikator

Aufgrund seiner schnellen Berechenbarkeit bei guter Erkennungsrate sehr beliebt ist auch der Naive Bayes-Klassifikator. Mittels des naiven Bayes-Klassifikators ist es möglich, die Zugehörigkeit eines Objektes (Klassenattribut) zu einer Klasse zu bestimmen. Er basiert auf dem Bayesschen Theorem. Man könnte einen naiven Bayes-Klassifikator auch als sternfömiges Bayessches Netz betrachten.

Grundannahme ist dabei, dass jedes Attribut nur vom Klassenattribut abhängt. Obwohl dies in der Realität selten zutrifft, erzielen naive Bayes-Klassifikatoren bei praktischen Anwendungen häufig gute Ergebnisse, solang die Attribute nicht zu stark korreliert sind.

Für den Fall starker Abhängigkeiten zwischen den Attributen ist eine Erweiterung des naiven Bayes-Klassifikators um einen Baum zwischen den Attributen sinnvoll. Das Ergebnis wird Baumerweiterter naiver Bayes-Klassifikator genannt.

Mathematische Definition

Ein Bayes-Klassifikator b ist eine Funktion, die Vektoren aus dem f-dimensionalen reellwertigen Merkmalsraum auf eine Menge von Klassen C abbildet:

Für gewöhnlich gilt

oder

oder  für den Fall, dass zwei Klassen betrachtet werden oder

für den Fall, dass zwei Klassen betrachtet werden oder  , falls

, falls  Klassen betrachtet werden.

Klassen betrachtet werden.Die Wahrscheinlichkeitsdichte der Klasse

, sei durch pi gegeben. Die Wahrscheinlichkeit, dass ein gegebener Merkmalsvektor in die Klasse i gehört, ist also durch pi(x) gegeben.

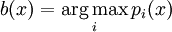

, sei durch pi gegeben. Die Wahrscheinlichkeit, dass ein gegebener Merkmalsvektor in die Klasse i gehört, ist also durch pi(x) gegeben.Der Bayes-Klassifikator ist dann nach dem a-posteriori-Kriterium definiert als:

Klassifizierung bei normalverteilten Klassen

Werden zwei Klassen durch Normalverteilungen beschrieben, so ist die aus dem Bayes-Klassifikator resultierende Entscheidungsgrenze dazwischen quadratisch. Werden die Normalverteilungen darüber hinaus durch die gleiche Kovarianzmatrix beschrieben, ist die dazwischen liegende Entscheidungsgrenze sogar linear. In diesen beiden Fällen lässt sich die Diskriminanzfunktion besonders einfach beschreiben, was die Klassifikation einfach und effizient berechenbar macht.

Siehe auch

- Bayes-Theorem

- Probabilistisches Retrieval

- Kostenmatrix

- Mustererkennung

- Klassifikationsverfahren

Wikimedia Foundation.