- Gauss-Newton-Verfahren

-

Das Gauß-Newton-Verfahren (nach Carl Friedrich Gauß und Isaac Newton) ist ein numerisches Verfahren zur Lösung nichtlinearer Minimierungsprobleme, die durch Anwendung der Methode der kleinsten Quadrate auf nichtlineare Ausgleichsprobleme entstehen. Das Verfahren ist eine Erweiterung/Vereinfachung des Newton-Verfahren, bei dem in jedem Schritt die zu minimierende Funktion durch eine quadratische Näherung ersetzt wird, deren Minimum explizit berechnet werden kann. Wegen der speziellen Struktur der zu minimierenden Funktion ("Summe von Fehlerquadraten") benötigt das Gauss-Newton-Verfahren im Gegensatz zum Newton-Verfahren jedoch nicht die zweite Ableitung der Funktion.

Inhaltsverzeichnis

Grundzüge des Verfahrens

Im folgenden wird angenommen, dass Daten mit folgenden Merkmalen vorliegen:

- Die Tabelle der Messwerte hat k Zeilen, es wurden also k Messungen durchgeführt

- Bei jeder Messung wurden n Stellgrößen

vorgegeben und das Ergebnis y gemessen

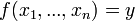

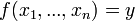

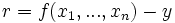

vorgegeben und das Ergebnis y gemessen - Es gibt eine Modellfunktion

, welche den Zusammenhang zwischen

, welche den Zusammenhang zwischen  und y beschreibt. Diese Funktion hat p verschiedene Parameter

und y beschreibt. Diese Funktion hat p verschiedene Parameter  , die nun so berechnet werden sollen, dass mit der Funktion y möglichst genau aus den

, die nun so berechnet werden sollen, dass mit der Funktion y möglichst genau aus den  berechnet werden kann. Das besondere an der Funktion ist, dass sie nichtlinear in den Parametern ist.

berechnet werden kann. Das besondere an der Funktion ist, dass sie nichtlinear in den Parametern ist.

Es ist dabei nicht notwendig, dass die Anzahl p der Parameter a gleich der Anzahl der Variablen x ist. Sucht man z. B. die Koeffizienten eines kubischen Polynoms, so liegt nur ein x je Datensatz vor, aber beim kubischen Polynom hat jede Potenz einen eigenen Koeffizienten a, so dass (einschließlich des absoluten Gliedes) vier Koeffizienten zu bestimmen wären.

Wenn die Messungen als Tabelle vorliegen, können sie so dargestellt werden:

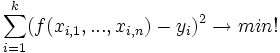

Der Ansatz, die Summe der Fehlerquadrate zu minimieren, liefert:

Algorithmus

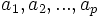

Zur Bestimmung der Parameter

geht man nach diesem Schema vor:

geht man nach diesem Schema vor:Vorbereitung

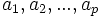

- Gegeben ist die Funktion

mit n Variablen

mit n Variablen  und p gesuchten Parametern

und p gesuchten Parametern

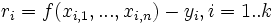

- Aufstellen der Residuumsfunktion

und des Residuenvektors

und des Residuenvektors

mit

mit

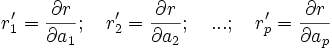

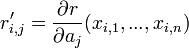

- Berechnung der partiellen Ableitungen der Residuumsfunktion

nach jedem Parameter (

nach jedem Parameter ( ):

):

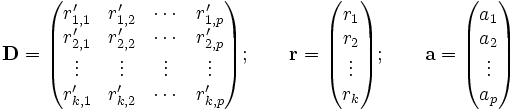

- Aufbau der Matrizen für die Iteration:

- Dabei ist

die Jacobi-Matrix des Residuenvektors

die Jacobi-Matrix des Residuenvektors  in Abhängigkeit vom Parametervektor

in Abhängigkeit vom Parametervektor  .

. - Für den Aufbau der Matrizen ist folgendes zu beachten:

- Die Matrix D und der Spaltenvektor r haben k Zeilen, also für jede Zeile der oben angegebenen Tabelle eine.

- Der Spaltenvektor a hat p Zeilen, also für jeden Parameter

eine

eine - Die Spalten in der Matrix D sind die partiellen Ableitungen nach den Parametern

. Die Reihenfolge der Spalten in D hängt mit der Reihenfolge der Parameter in a zusammen. Steht in Zeile 1 von a der Parameter

. Die Reihenfolge der Spalten in D hängt mit der Reihenfolge der Parameter in a zusammen. Steht in Zeile 1 von a der Parameter  , so muss in D die erste Spalte die Ableitungen nach

, so muss in D die erste Spalte die Ableitungen nach  enthalten. Dementsprechend hat D p Spalten, also für jeden Parameter

enthalten. Dementsprechend hat D p Spalten, also für jeden Parameter  eine.

eine.

- Die Anzahl der Variablen n hat keinen Einfluss auf den Aufbau der Matrix D und der beiden Vektoren r, a.

- Zu Beginn der Iteration müssen Startwerte für die Parameter

und eine Fehlerschranke

und eine Fehlerschranke  , die größer Null sein muß, festgelegt werden.

, die größer Null sein muß, festgelegt werden.

Iteration

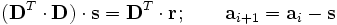

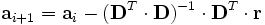

- Die Iteration wird mit folgender Matrixgleichung durchgeführt:

- Dabei wird in jedem Schritt der Vektor

, der die Parameter

, der die Parameter  enthält, verbessert.

enthält, verbessert. - Die Matrix D wird berechnet, indem man zunächst alle Werte in den k Zeilen der Tabelle in die Funktion

einsetzt. Das Ergebnis schreibt man untereinander in die Spalte 1 von D. Danach setzt man alle Werte in den k Zeilen der Tabelle in die Funktion

einsetzt. Das Ergebnis schreibt man untereinander in die Spalte 1 von D. Danach setzt man alle Werte in den k Zeilen der Tabelle in die Funktion  ein und schreibt sie in Spalte 2 der Matrix D usw.

ein und schreibt sie in Spalte 2 der Matrix D usw. - Um den Vektor r zu berechnen, setzt man alle Werte in den k Zeilen der Tabelle in die Funktion

und schreibt die Ergebnisse jeweils untereinander als Vektor r auf.

und schreibt die Ergebnisse jeweils untereinander als Vektor r auf. - Für die numerische Berechnung empfiehlt sich eine Aufspaltung der Berechnung, damit die Matrixinversion durch die Lösung eines linearen Gleichungssystems für den unbekannten Lösungsvektor s ersetzt werden kann:

- Die Vorteile liegen in einer schnelleren Berechnung bei höherer Genauigkeit.

- Sobald

berechnet wurde, müssen auch Matrizen neu berechnet werden, um den nächsten Iterationsschritt vorzubereiten. Um den Rechenaufwand zu verringern, kann auch mehrfach ohne Neuberechnung von s iteriert werden. Dieses Vorgehen wird beim Newtonschen Verfahren häufig empfohlen, reduziert aber die Konvergenzgeschwindigkeit und sollte erst angewendet werden, wenn sich a nur noch wenig ändert.

berechnet wurde, müssen auch Matrizen neu berechnet werden, um den nächsten Iterationsschritt vorzubereiten. Um den Rechenaufwand zu verringern, kann auch mehrfach ohne Neuberechnung von s iteriert werden. Dieses Vorgehen wird beim Newtonschen Verfahren häufig empfohlen, reduziert aber die Konvergenzgeschwindigkeit und sollte erst angewendet werden, wenn sich a nur noch wenig ändert.

- Die Iteration wird abgebrochen, falls

, also bei den

, also bei den  der Betrag der Änderung unterhalb der Fehlerschranke

der Betrag der Änderung unterhalb der Fehlerschranke  liegt.

liegt.

Anmerkungen

- Da

symmetrisch und positiv definit ist, eignet sich die Cholesky-Zerlegung besonders gut für die Auflösung des Gleichungssystems.

symmetrisch und positiv definit ist, eignet sich die Cholesky-Zerlegung besonders gut für die Auflösung des Gleichungssystems.

- Die Anzahl der Zeilen in der Tabelle (k) muss stets größer als die Anzahl der Parameter

sein. Falls die Anzahl der Parameter gleich k ist, bestimmt das Verfahren die Parameter exakt (im Rahmen der Genauigkeit der Iteration), es ist also nicht nur die optimale Lösung im Sinne der Fehlerquadrate. Das System ist unterbestimmt, wenn die Anzahl der Parameter größer als k ist.

sein. Falls die Anzahl der Parameter gleich k ist, bestimmt das Verfahren die Parameter exakt (im Rahmen der Genauigkeit der Iteration), es ist also nicht nur die optimale Lösung im Sinne der Fehlerquadrate. Das System ist unterbestimmt, wenn die Anzahl der Parameter größer als k ist.

- Um eine konvergente Näherung zu erreichen, sollte man eine grobe Vorstellung über die Größenordnung der Parameter haben. Das Verfahren divergiert, wenn die Startwerte der Parameter

ungünstig gewählt wurden.

ungünstig gewählt wurden.

- Durch Einführung eines Schrittweiteparameters γ lässt sich ein Abstieg, d. h. die Verringerung der Fehlerquadratsumme erzwingen, indem die Funktion an der neuen Stelle für verschiedene γ ausgewertet wird (siehe auch Levenberg-Marquardt-Algorithmus).

- Je näher die Fehlerschranke

bei Null liegt, umso genauer wird die Lösung; allerdings mit der Nebenwirkung, dass sich die Zahl der Iterationen erhöht.

bei Null liegt, umso genauer wird die Lösung; allerdings mit der Nebenwirkung, dass sich die Zahl der Iterationen erhöht.

Unterschied zwischen Gauss-Newton-Verfahren und Newton-Verfahren

Beim Newton-Verfahren werden die Jacobi- und Hesse-Matrix benutzt, um das Minimum einer nichtlinearen-Funktion (in diesem Fall der Summe der Fehlerquadrate) iterativ zu bestimmen.

Im Gauss-Newton-Verfahren hingegen hat man immer eine Summe von Fehlerquadraten (zwischen Messwerten und Funktionswerten), die iterativ minimiert werden soll. Jede einzelne der Funktionen wird im Gauss-Newton-Schritt durch eine lineare Näherung ersetzt (Taylor-Reihe erster Ordnung). Die Summe der Fehlerquadrate ist damit quadratisch in den Parametern und kann explizit gelöst werden, ohne dass die exakte Hesse-Matrix der Summe der Fehlerquadrate benötigt würde (Voraussetzung für das Newton-Verfahren). Ist der Schritt berechnet, wird (wie beim Newton-Verfahren) der Schritt an der neuen Stelle wiederholt.

Literatur

- Ralf Pfeifer: Effektive Messauswertung mit der Gauß'schen Fehlerquadratmethode, ISBN 3-89001-251-5

Weblinks

- www.ArsTechnica.de Excel-Berechnungsbeispiel für den Luft- und Rollwiderstand eines Fahrzeuges mit Ausrollversuchen

- www.mathematik-online.de Ausführliche Beispielrechnung für die Anpassung eines Kreises an Messdaten

Wikimedia Foundation.