- Hermiteinterpolation

-

In der numerischen Mathematik ist die Hermiteinterpolation (benannt nach Charles Hermite) ein Interpolationsverfahren zur Polynominterpolation, das auch Ableitungen der zu interpolierenden Funktion berücksichtigt.

Inhaltsverzeichnis

Vorbereitung

Motivation

Ein Ergebnis für die klassische Polynominterpolation besagt, dass äquidistante Stützstellen – also gleicher Abstand zwischen den bekannten Funktionswerten – zu einem exponentiellem Anstieg der Kondition der Polynominterpolation führt, ihren Fehler also drastisch erhöht.[1]

Da äquidistante Messpunkte in der Praxis aber praktisch, bisweilen auch unvermeidbar, sind, benötigt man ein Interpolationsverfahren, das auch für diesen Fall nur kleine Fehler erzeugt. Ein Ansatz ist die Splineinterpolation, bei der das Gebiet, auf dem eine Funktion interpoliert werden soll, durch ein Gitter zerteilt und in jedem der entstandenen Intervalle eine Polynominterpolation durchgeführt wird.

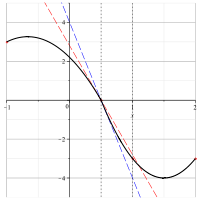

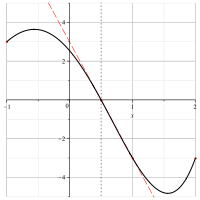

Wählt man dabei den „naiven“, Newtonschen Ansatz, stimmen die Ableitungen der Interpolierten an den Gitterpunkten nicht notwendigerweise überein – folglich ist die Interpolierte an diesen Punkten in der Regel nicht (stetig) differenzierbar. Es muss nicht bei „Ecken“, wie im Beispiel rechts, bleiben. Es könnte zum Beispiel auch passieren, dass auf zwei benachbarten Intervallen die Interpolierten sich „von oben“ dem Gitterpunkt nähern und so tatsächlich eine – anschaulich – „Spitze“ entsteht.

Da dieses Verhalten offensichtlich unerwünscht ist, versucht man, die Übergänge glatt zu gestalten, indem man neben den Funktionswerten in den Gitterpunkten weiterhin beliebig viele Ableitungen als bekannt voraussetzt und die Interpolationspolynome so wählt, dass die Ableitungen in dem gemeinsamen Punkt übereinstimmen. Praktisch reicht es, die erste Ableitung gleichzusetzen, um einen „glatt“ aussehenden Graphen zu erhalten.

Diese Aufgabe lässt sich analog zur Problemstellung in der klassischen Polynominterpolation schriftlich lösen. Als Beispiel dient hier die Aufgabe,

in

in  zu interpolieren.

zu interpolieren.

Man definiert

und leitet ab zu

und leitet ab zu  .

.

Das Gleichungssystem wird damit zu

Lösen nach a = (a0,a1,a2)T bringt die gesuchten Koeffizienten.

Dieser Lösungsansatz hat den Nachteil, dass er in der Komplexitätsklasse

und damit langsam ist. Es wäre wünschenswert, die Newton-Basis von der klassischen Polynominterpolation übernehmen zu können. Dieser Ansatz schließt allerdings zusammenfallende Stützstellen aus und ist daher nicht ohne Modifikation anwendbar. Daher erweitert man ihn zum Hermitschen Interpolationsverfahren.

und damit langsam ist. Es wäre wünschenswert, die Newton-Basis von der klassischen Polynominterpolation übernehmen zu können. Dieser Ansatz schließt allerdings zusammenfallende Stützstellen aus und ist daher nicht ohne Modifikation anwendbar. Daher erweitert man ihn zum Hermitschen Interpolationsverfahren.Hermite-Genocchi-Formel

Die Hermite-Genocchi-Formel bildet die Grundlage der Hermiteinterpolation. Sie liefert eine Integraldarstellung für die dividierten Differenzen aus dem Newtonalgorithmus der Polynominterpolation:

mit dem k-dimensionalen Einheitssimplex

Man beweist diese Identität durch Vollständige Induktion.[2]

Im Gegensatz zu den dividierten Differenzen taucht im Integral in dieser Formel kein Quotient mit der Differenz zweier Stützstellen auf – rein rechnerisch ist es also möglich, konfluente (zusammenfallende) Stützstellen einzusetzen. Stellt man die Formel als

dar, lässt sich diese Identität einfach beweisen.

Offensichtlich kann man folglich durch mehrfaches Verwenden von Stützstellen Ableitungen in der Interpolation berücksichtigen.

Also gilt der folgende Satz:

Hermiteinterpolation

Sei

![f \in C^k([\alpha, \beta])](2/2d237277366acd25d11b9448877a8735.png) und seien

und seien  reelle Stützstellen. Dann erfüllt das Polynom

reelle Stützstellen. Dann erfüllt das Polynomdie Interpolationsbedingungen

Darüber hinaus ist diese Lösung eindeutig.

Fehlerabschätzung

Für den Fehler der Hermiteinterpolierten gilt nach dem Fehler in der Taylorentwicklung die obere Schranke

Im Falle des Gitters

gilt:

Berechnung der Interpolierten

Zur praktischen Berechnung der Interpolierten verwendet man wie gehabt das Schema der dividierten Differenzen.

Im Fall

muss anstatt der dort verwendeten Formel

muss anstatt der dort verwendeten Formelberechnet werden.

Zu beachten ist, dass ferner einige Umsortierungen notwendig sind. Im Folgenden sei

:

:- Statt

![f[x_i,\ldots,x_k]](b/1cb192852c95de675566dcf459513c49.png) muss man die dividierte Differenz

muss man die dividierte Differenz ![f[x_0,\ldots,x_{k-i}]](3/4936450c4109a7cb3db4403ef59e74e1.png) berechnen

berechnen - Taucht in der Rekursion f[xi] auf, berechnet man stattdessen f[x0]

- In allen Fällen, in denen die Formel aus dem ursprünglichem Neville-Aitken-Schema verwendet wird, ersetzt man jedes xi durch x0.

Pseudocode

Der Pseudocode soll verdeutlichen, wie man die verallgemeinerte Form der dividierten Differenzen berechnet. Listen werden im folgenden als ab 1 indiziert angenommen.

xvals ← Stützstellen yvals ← Funktionswerte f(x) und ggf. Ableitungen bei mehrfachen x-Werten zvals ← { f(xvals[i]) | i ∈ 1..#xvals } for i ← #xvals..1 do for j ← i..#xvals do if i = j then [xi..xj]f ← zvals[i] else if xvals[i] = xvals[j] then index ← Index des ersten Vorkommens von xvals[i] in xvals [xi..xj]f ← yvals[j - i + index] / (j-i)! else [xi..xj]f ← ([xi+1..xj]f - [xi..xj-1]f) / (xvals[j] - xvals[i])Weblinks

Wikibooks: Hermiteinterpolation – Implementierungen in der Algorithmensammlung

Wikibooks: Hermiteinterpolation – Implementierungen in der AlgorithmensammlungLiteratur

- Burden, Richard L., and J. Douglas Faires. Numerical Analysis. Belmont: Brooks/Cole, 2004.

Einzelnachweise

- ↑ Turetskii, A. H, The bounding of polynomials prescribed at equally distributed points; Proc. Pedag. Inst. Vitebsk; 3; 1940.

Siehe auch Runges Phänomen - ↑ Ralf Kornhuber, Christof Schütte; AG Numerische Mathematik (Hrsg.): Einführung in die Numerische Mathematik. Freie Universität Berlin April 2008, 3.1.1 Hermite-Interpolation und Taylor’sche Formel, S. 39-45 (Vorlesungsskript, PDF, 2.4 MB).

Wikimedia Foundation.

![f[x_0,\ldots,x_k] = \int_{\Sigma^k}f^{(k)}\left(x_0+\sum_{i=1}^k s_i(x_i-x_0)\right)\,ds ,](7/e873c1ef311439611381a4de82624639.png)

![f[x_0,\ldots,x_k] = \frac{1}{k!}f^{(k)}(x_0)](3/2c36029bb804b5c6235403ac7ab92ea3.png)

![p(x) := \sum_{i=0}^{n} f[x_0,\ldots,x_i] \prod_{j=0}^{i-1}(x-x_j)](b/8fbfb9c49d395b9171e6f9e3ae351a46.png)

![f(x) - p(x) = \frac{f^{(n+1)}(\zeta)}{(n+1)!} \prod_{i=0}^n (x-x_i),\;\zeta \in [\alpha,\beta] , \; f \in C^{n+1}](8/03871f60fd296198b28899bae71cf8bc.png)