- Videokomprimierung

-

Mit Hilfe der Videokompression lässt sich die Datenrate eines digitalisierten Videosignals beziehungsweise, nach Speicherung, der Platzbedarf einer Videodatei um ein Vielfaches verkleinern. Unter anderem standardisiert die Moving Picture Experts Group (MPEG) Verfahren zur Videokodierung und Audiokodierung.

Die Datenrate eines digitalisierten herkömmlichen Farbfernsehsignals inklusive Austastlücke liegt bei 216 Mbit/s (Megabit pro Sekunde); nach Weglassen der Austastlücke beträgt sie immer noch 166 Mbit/s. Die hohe Kompressionsrate – das heißt hohe Bildqualität in DVD-Auflösung bei einer Datenrate von nur etwa 1 Mbit/s – des MPEG-4 Standards und vergleichbarer neuer Verfahren ist in einer Reihe von Techniken zur Entfernung von irrelevanten und redundanten Informationen begründet.

Die Bildcodierung nach JPEG war ursprünglich für die Kompression von Standbildern (Fotos etc.) festgelegt worden und legte auch ein Dateiformat fest, das mit Formaten aus dem Computerbereich wie zum Beispiel Postscript Level 2 oder Apple Quicktime übereinstimmte.

Für Bewegtbilder wurden daraus mehrere inkompatible Motion-JPEG-Verfahren entwickelt, die allerdings trotzdem im Bereich von Videoschnittsystemen zu finden sind. Bei Motion-JPEG wird jedes Bild eines Filmes einzeln als Standbild komprimiert, während bei echter Videokompression zusätzlich auch die meist hohe Ähnlichkeit direkt aufeinanderfolgender Bilder zur Informationsreduzierung ausgenutzt wird.

Inhaltsverzeichnis

Physiologische Grundlage von Videokompression

Die Kompressionsalgorithmen beruhen auf den physiologischen Erkenntnissen der Genauigkeit des menschlichen Sehvermögens.

Da die Farbauflösung aufgrund der Anatomie des Auges schlechter ist als die Auflösung von Helligkeitsunterschieden, kann man die Auflösung der Farbinformationen verringern, ohne dass die Unterschiede stark wahrgenommen werden könnten. Man spricht dabei von Chroma Subsampling. Viele Kompressionsverfahren verwenden diese Technik als einen ersten Schritt zur Reduktion.

Eine weitere Eigenschaft des visuellen Systems, die ausgenutzt werden kann, ist die Frequenzabhängigkeit. Man kann Bilder, ähnlich wie Töne, auch als Überlagerung von zweidimensionalen Schwingungen darstellen. Niedrige Bildfrequenzen sind für grobe Bildstrukturen verantwortlich, hohe für feine Details. Störungen in den verschiedenen Frequenzbereichen werden unterschiedlich stark wahrgenommen, was an einem einfachen Testbild gut verdeutlicht werden kann.

Diese Frequenzabhängigkeit wird über die Verwendung einer geeigneten Transformation in allen Videokompressionsverfahren der MPEG-Familie verwendet.

Mathematische Grundlagen

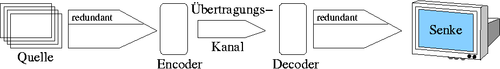

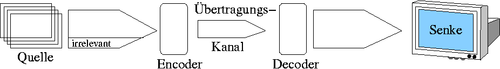

Die Begriffe Redundanzreduktion und Irrelevanzreduktion stammen aus der Informationstheorie und beschreiben zwei verschiedene Ansätze zur Reduktion der Datenmenge, auch Datenkompression genannt, bei der Übertragung von Information. Dabei wird auf ein Modell zurückgegriffen, bei dem Information von einer Quelle zur Senke übertragen wird. Auf den konkreten Fall der Videokodierung übertragen, entspricht die Quelle der Folge von Videobildern wie sie in der ursprünglichen Kamera entstehen, die Senke entspricht dem Auge des Betrachters.

Redundanzreduktion

Die Redundanzreduktion berücksichtigt die Eigenschaften der Quelle mit dem Ziel, die zu übertragende Datenmenge zu reduzieren. Im Fall der Videokodierung werden statistische Eigenschaften des Bildsignals, zum Beispiel Korrelation zwischen zeitlich und räumlich benachbarten Bildpunkten, ausgenutzt, um möglichst kompakten Code zu erzeugen. Dabei kommt die Kodierung mit variabler Codewortlänge (VLC „variable length coding“) zum Einsatz. Statt alle zu übertragende Symbole mit konstanter Codewortlänge zu kodieren, werden häufiger auftretende beziehungsweise wahrscheinlichere Symbole mit kürzeren Codewörtern kodiert als seltenere Symbole. Da keine Informationen verloren gehen, spricht man von verlustloser Kodierung.

Irrelevanzreduktion

Die Irrelevanzreduktion zielt darauf ab, diejenige Information bei der Übertragung auszulassen, die für die Senke nicht relevant ist. Konkret bedeutet dies im Fall der Videokodierung, dass nur ein Teil der Bilddaten übertragen wird. Dabei werden jene dadurch entstehenden Verzerrungen zugelassen, bei denen für den menschlichen Betrachter möglichst wenige Störungen wahrgenommen werden. Da Informationen verloren gehen, spricht man von verlustbehafteter Kodierung.

Vorwärts gerichtete diskrete Kosinustransformation

Bei der vorwärts gerichteten diskreten Kosinustransformation (FDCT) wird das einzelne Videobild (Frame) in 8x8 große Pixel-Blöcke unterteilt, und diese werden nach ihrer Komplexität beurteilt. Dieser Schritt ist notwendig, damit der Codec „weiß“, für welche (komplexen) Pixelblöcke er viel Speicherplatz benötigt und für welche (einfachen) Blöcke weniger Bits genügen. Dies ist die Voraussetzung für die Irrelevanzreduktion.

Bewegungskorrektur

Eine weitere Möglichkeit zur Verkleinerung der Datenmenge ist die Bewegungskorrektur (englisch motion compensation): Es werden nur die Unterschiede zum vorhergehenden Bild gespeichert. Es wird nach Pixelblöcken gesucht, die gegenüber dem letzten Frame verändert wurden. Für diese wird ein Bewegungsvektor gespeichert, die unbewegten werden einfach vom letzten Frame übernommen.

Siehe auch

Wikimedia Foundation.