- Metaanalyse

-

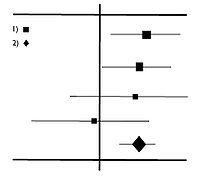

Eine Metaanalyse ist eine Zusammenfassung von Primär-Untersuchungen zu Metadaten, die mit quantitativen, statistischen Mitteln arbeitet. Der Begriff wurde 1976 vom Psychologen Gene V. Glass (* 1940) in seinem Artikel "Primary, Secondary and Meta-Analysis of Research" eingeführt. Er definiert Metaanalyse als [...] analysis of analyses. I use it to refer to the statistical analysis of a large collection on analysis results from individual studies for the purpose of integrating the findings. (deutsch: „[...] Analyse von Analysen. Damit meine ich die statistische Analyse einer großen Sammlung von Analyse-Ergebnissen mehrerer Einzelstudien, die dadurch zusammengeführt werden sollen.“).[1] Durchgeführt wurde die erste Metaanalyse jedoch bereits 1904 von Karl Pearson, der die Teststärke von Studien mit wenigen Probanden durch Zusammenfassen erhöhen wollte.

Im Gegensatz zur Methode der Metaanalyse stehen qualitative Verfahren, bei denen auf dem Wege subjektiver Einschätzung versucht wird, aus dem Inhalt der Primärstudien Schlüsse zu ziehen. Beim Verwenden von qualitativen Verfahren ist eine fehlerhafte Schlussfolgerung oder Auswertung wesentlich einfacher möglich als beim Einsatz einer Metaanalyse.[2]

Inhaltsverzeichnis

Einsatzgebiete und Gründe

Metaanalysen ermöglichen die Zusammenfassung von verschiedenen Untersuchungen zu einem wissenschaftlichen Forschungsgebiet. Dabei werden die empirischen Einzelergebnisse inhaltlich homogener Primärstudien zusammengefasst. Ziel ist eine Effektgrößeneinschätzung. Es soll untersucht werden, ob ein Effekt vorliegt und wie groß dieser ist.

Metaanalysen werden v. a. in der Medizin, Psychologie und der empirischen Sozialforschung häufig eingesetzt. Dort helfen sie bei zwei Problemen:

- Aus mancherlei Gründen sind die Stichproben der Primärstudien viel zu klein, um verlässliche Ergebnisse zu bringen: kann man nun viele Untersuchungen geeignet zusammenfassen, so ist das damit gewonnene Ergebnis sehr viel genauer und sicherer.

- Häufig benutzen die Primärstudien nicht genau dieselben Methoden, Definitionen oder ziehen ihre Stichproben nicht aus derselben Grundgesamtheit. Dann ist zunächst einmal fraglich, ob und wie man diese Einflüsse von dem Gegenstand der Untersuchung überhaupt trennen kann.

Methode

Eine Metaanalyse umfasst sämtliche Elemente des sozialwissenschaftlichen Forschungsprozesses wie sie auch bei einer Primärforschung vollzogen werden (Cooper 1982; Schnell et al. 1995).

- Am Beginn stehen die Auswahl eines geeigneten Forschungsproblems sowie die genaue Eingrenzung des Forschungsgegenstandes.

- Die Datenerhebung besteht im Fall publikationsbasierter Metaanalysen in einer systematischen und möglichst erschöpfenden Literaturrecherche.

- Im Anschluss daran werden die Informationen in den gesammelten Publikationen vercodet und elektronisch aufbereitet.

- Die eigentliche (statistische) Datenanalyse besteht in der Regel aus zwei Schritten: der Befundintegration und der anschließenden Heterogenitätsanalyse.

- Abschließend sind die Ergebnisse angemessen aufzubereiten und mit Bezug auf das Forschungsproblem zu interpretieren.

Das Verfahren der Metaanalyse ähnelt dem narrativen Review, das die einschlägige Literatur zu einem wissenschaftlichen Thema strukturiert vorstellt und mit kritischen Kommentaren versieht. Kritisiert wird die Subjektivität der Auswahl von Untersuchungen. Hier erreicht die Metaanalyse eine größere Objektivität, indem sie Kriterien für die Auswahl der Primärstudien für die Metaanalyse festlegt, dadurch verringert sich hingegen die mögliche Anzahl der Untersuchungen, die in eine Metaanalyse aufgenommen werden können.

Die Zusammenfassung verschiedener Untersuchungen zu einem wissenschaftlichen Forschungsgebiet ist nur sinnvoll, wenn die Effektgrößen der einzelnen Untersuchungen Schätzungen einer gemeinsamen Populationseffektgröße sind. Es ist eine Homogenitätsprüfung notwendig.

Homogenitätsprüfungen gehen von einer einheitlichen Effektgröße Δ (sprich: Delta) aus. Δ ist ein universelles Effektgrößenmaß und entspricht der bivariaten Produkt-Moment-Korrelation. Es wird präferiert, da verschiedene statistische Kennwerte (z. B. r, t, F) in Δ transformiert werden können.

Die studienspezifischen Effektgrößen werden anschließend durch einen Signifikanztest auf Homogenität geprüft. Sind die Effektgrößen homogen, kann ein durchschnittlicher Δ-Wert berechnet werden, er entspricht der Schätzung der Populationseffektgröße und kann auf Signifikanz geprüft und hinsichtlich seiner Größe klassifiziert werden.

Liegen heterogene Effektgrößen vor, so kann man Strategien anwenden, die die Untersuchungen mit heterogenen Effektgrößen in homogene Subgruppen teilen. Anschließend sollte der Einfluss von Moderatorvariablen auf die Heterogenität bestimmt werden, dies geschieht varianz- oder clusteranalytisch. Bestehen keine direkten Annahmen über die Wirkung von Moderatorvariablen kann auch eine Korrelation zwischen den Moderatorvariablen und den studienspezifischen Effektgrößen berechnet werden. Die Höhe der Korrelation beschreibt dabei den Einfluss der Moderatorvariablen auf die Heterogenität der einzelnen Effektgrößen.

Da Untersuchungsberichte häufig lückenhaft sind und teils nur über signifikante, bzw. nicht-signifikante Ergebnisse berichtet wird, gibt es Verfahren, die es ermöglichen, auch diese Untersuchungen metaanalytisch zu verwenden (z. B. Auszählung, Vorzeichentest, Binomialtest und Berechnung der exakten Irrtumswahrscheinlichkeit, es resultiert die Stouffer-Prüfgröße). Mit Hilfe des ’fail-safe N‘ (nach Rosenthal) lässt sich beim Vorliegen eines signifikanten Gesamttests ausrechnen, wie viele Studien mit einem mittleren Effekt der Größe Null noch zusätzlich vorhanden sein müssten, damit der Gesamttest nicht signifikant ist.

Kritik

Garbage-in – Garbage-out –Problem: Kritisiert wird, die Ergebnisse einer Metaanalyse seien wenig valide, weil jede beliebige Untersuchung, unabhängig ihrer methodischen Qualität in die Metaanalyse eingeht. Allerdings kann der Einfluss der methodischen Qualität der Untersuchungen auf das Ergebnis der Metaanalyse kontrolliert werden, indem Bewertungskriterien herangezogen werden, anhand derer die Ergebnisse einer Untersuchung bewertet und ihre Effektgröße damit gewichtet werden kann.

Äpfel-Birnen-Problem: Kritisiert wird, dass Metaanalysen Untersuchungen mit unterschiedlichen Operationalisierungsvarianten zusammenfassen. Es wird gefordert, dass vor allem in Bezug auf die abhängige Variable homogene Operationalisierungen vorliegen müssen, da sie alle Indikatoren für das gleiche Konstrukt sein sollen. Andernfalls beziehen sich die Untersuchungen auf unterschiedliche Kriterien, eine Zusammenfassung wäre dann nicht sinnvoll.

Schubladenproblem: Häufig werden nur Ergebnisse publiziert, die angenommene Hypothesen bestätigen oder signifikante Ergebnisse aufweisen, während Untersuchungen mit nicht-signifikanten Ergebnissen nicht veröffentlicht werden (Publikationsbias). Dadurch erfolgt eine Verzerrung der metaanalytischen Ergebnisse, da diese die Existenz eines Effekts zu oft nachweisen.[3] Unveröffentlichte Literatur bezeichnet man auch als graue Literatur. „Interessanterweise hatte die graue Literatur in der ehemaligen DDR als nicht zensierte Literatur meist einen höheren wissenschaftlichen Wert als die offizielle, staatlich kontrollierte Literatur.“ [4] „Eine Liste der neuesten Diplomarbeiten und Dissertationen im Fach Psychologie ist halbjährlich der Psychologischen Rundschau beigelegt“ [4]Das Problem an graue Literatur heranzukommen wird bei M.C. Rosenthal[5] (1994) behandelt.[3]

Problem der abhängigen Messungen: Dieses Problem tritt auf, wenn verschiedene (abhängige) Teilergebnisse an der gleichen Stichprobe erhoben worden sind. Da Untersuchungseinheiten von Metaanalysen aber Einzelstudien und nicht Teilstichproben sind, darf immer nur ein Ergebnis einer Untersuchung in die Metaanalyse mit eingehen, da andernfalls diese Untersuchung ein größeres Gewicht erhalten würde, als eine Untersuchung, die nur mit einem Ergebnis in die Metaanalyse eingeht. Entweder wählt man das wichtigste Ergebnis unter den Teilergebnissen oder man bildet das arithmetische Mittel als Schätzung des Gesamtergebnisses.

Literatur

- Harris M. Cooper: Scientific guidelines for conducting integrative research reviews. In: Review of Educational Research 52, 1982, ISSN 0034-6543, S. 291–302.

- Harris Cooper, Larry V. Hedges (Hrsg.): The Handbook of Research Synthesis. Russell Sage Foundation, New York NY 1994, ISBN 0-87154-226-9.

- Gene V. Glass: Primary, Secondary and Meta-Analysis of Research. In: Educational Researcher 5, 1976, ISSN 0013-189x, S. 3–8.

- Joachim Hartung, Guido Knapp, Bimal K. Sinha: Statistical meta-analysis with applications. J. Wiley & Sons, Inc., Hoboken NJ 2008, ISBN 978-0-470-29089-7, (Wiley Series in Probability and Statistics).

- John E. Hunter, Frank L. Schmidt, Gregg B. Jackson: Meta-Analysis. Cumulating research findings across studies. Sage Publications, Beverly Hills CA 1982, ISBN 0-8039-1864-X, (Studying organizations 4), (Empfehlenswerte Einleitung).

- Rainer Schnell, Paul B. Hill, Elke Esser: Methoden der empirischen Sozialforschung. 5. völlig überarbeitete und erweiterte Auflage. Oldenbourg Verlag, München u. a. 1995, ISBN 3-486-23489-7.

Weblinks

- http://www.stat-help.com/meta.pdf (Einführung; PDF-Datei; 250 kB)

- http://www.lyonsmorris.com/MetaA/index.htm (Tutorial)

- The Scientist, Sep. 15, 1997 Stephen P. Hoffert: Meta-Analysis Gaining Status In Science And Policymaking

- http://faculty.ucmerced.edu/wshadish/index.htm (Software)

- Probleme der Metaanalyse

Einzelnachweise

- ↑ Glass, G.V. (1976). Primary, Secondary, and Meta-Analyses of Research. Educational Researcher, 5, 3-8.

- ↑ Beispiele bei Hunter/Schmidt/Jackson

- ↑ a b Jürgen Bortz und Nicola Döring: Forschungsmethoden und Evaluation, Springer Verlag, Heidelberg 2006, S. 674(online)

- ↑ a b Jürgen Bortz und Nicola Döring: Forschungsmethoden und Evaluation, Springer Verlag, Heidelberg 2006, S. 360 (online)

- ↑ R. Rosenthal: The Fugitive Literature. In H. Cooper und L. V. Hedges (Hrsg.), The Handbook of Research Synthesis, 1994, S. 85-94

Wikimedia Foundation.