Auffälligkeit (Informationstheorie)

- Auffälligkeit (Informationstheorie)

-

Die Auffälligkeit ist ein Maß für den Beitrag eines Zeichens an der Gesamtentropie eines Systems, das um 1965 von dem deutschen Kybernetiker Helmar Frank eingeführt wurde.

Definition

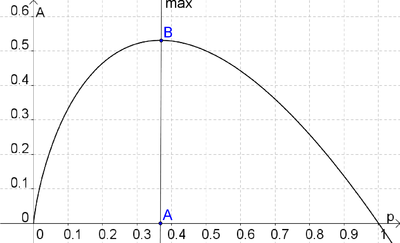

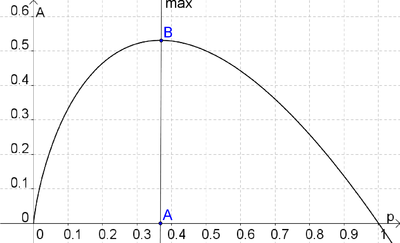

Die Funktion

Bei der Untersuchung der von Shannon eingeführten Entropie konzentrierte sich Frank auf den Term, der den Beitrag einzelner Wahrscheinlichkeiten zur Gesamtentropie liefert. Dieser Beitrag ist das Produkt aus der Wahrscheinlichkeit p eines Ereignisses und seines Informationsgehaltes (Überraschungswertes) I(p) = − log 2p:

-

Das Maximum dieser Funktion beträgt etwa  bei:

bei:

-

.

.

-

- (e - Eulersche Zahl)

Bei der Untersuchung zur Bedeutung dieser Funktion zog Frank, aufbauend auf den Arbeiten von Wilhelm Fucks, Parallelen zur menschlichen Wahrnehmung. Er definierte die Auffälligkeit eines Zeichens als seinen Beitrag zur Gesamtunsicherheit des Systems (Entropie)[1].

Interpretation

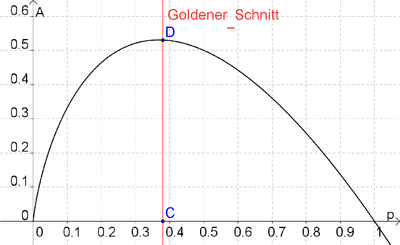

Frank und andere Wissenschaftler [2] [3] zogen Parallelen zwischen den Verhältnissen, die sich durch das Maximum der Auffälligkeit und den Goldenen Schnitt ergeben:

Maximum der Auffälligkeit:

-

Goldener Schnitt:

-

Daraus schlossen sie, das die Auffälligkeit eine informationstheoretische Erklärung für einen Aspekt des ästhetischen Empfindens ist.

Einzelnachweise

- ↑ Helmar G. Frank, Brigitte S. Meder: Einführung in die kybernetische Pädagogik, DTV Deutscher Taschenbuch, 1984, ISBN 3423041080

- ↑ Horst Völz: Computer und Kunst, Reihe akzent 87. 2. Aufl. Urania-Verlag Leipzig Jena - Berlin 1990 (ab Seite 14 der PDF-Version) ISBN 3332002201

- ↑ André Frank Zimpel: Der zählende Mensch. Was Emotionen mit Mathematik zu tun haben, Vandenhoeck & Ruprecht, 2008, ISBN 3525315422

Literatur

- Helmar G. Frank, Herbert W. Franke: Ästhetische Information. Estetika informacio. Eine Einführung in die kybernetische Ästhetik, Kopäd Verlag, 2002, ISBN 3929061821

Wikimedia Foundation.

Schlagen Sie auch in anderen Wörterbüchern nach:

Entropie (Informationstheorie) — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Das… … Deutsch Wikipedia

Überraschungswert — Der Begriff der Information, wie er in der Informationstheorie nach Shannon[1] verwendet wird, ist streng von dem gewöhnlichen Gebrauch dieses Begriffes zu unterscheiden. Insbesondere darf darin die Information nicht mit dem Begriff der Bedeutung … Deutsch Wikipedia

Informationsdichte — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Informationsentropie — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Maximale Entropie — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Maximalentropie — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Shannon-Entropie — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Shannonentropie — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

Der Goldene Schnitt — (lat. sectio aurea) ist ein bestimmtes Verhältnis zweier Zahlen oder Größen: Zwei Strecken stehen im Verhältnis des Goldenen Schnittes, wenn sich die größere zur kleineren Strecke verhält wie die Summe aus beiden zur größeren. Der Wert beträgt… … Deutsch Wikipedia

Goldene Schnitt — Der Goldene Schnitt (lat. sectio aurea) ist ein bestimmtes Verhältnis zweier Zahlen oder Größen: Zwei Strecken stehen im Verhältnis des Goldenen Schnittes, wenn sich die größere zur kleineren Strecke verhält wie die Summe aus beiden zur größeren … Deutsch Wikipedia

bei:

bei: .

.