- Logitmodell

-

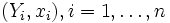

Unter logistischer Regression oder Logit-Modell versteht man ein Verfahren zur (meist multivariaten) Analyse diskreter (z. B. binärer) abhängiger Variablen. Hierbei hat man Daten

gegeben, wobei Yi einen binären Response bezeichnet, das heißt, Yi nimmt nur die Werte 0 oder 1 an. Des Weiteren bezeichnet xi einen bekannten und festen Kovariablenvektor und n die Anzahl der Beobachtungen.

gegeben, wobei Yi einen binären Response bezeichnet, das heißt, Yi nimmt nur die Werte 0 oder 1 an. Des Weiteren bezeichnet xi einen bekannten und festen Kovariablenvektor und n die Anzahl der Beobachtungen.Daniel McFadden und James Heckman haben im Jahre 2000 für ihren Beitrag zur Entwicklung des Logit-Modells den Nobelpreis für Wirtschaftswissenschaften verliehen bekommen.

Die Einflüsse auf solche Variablen können nicht mit dem Verfahren der linearen Regressionsanalyse untersucht werden, da wesentliche Anwendungsvoraussetzungen insbesondere in inferenzstatistischer Hinsicht (Normalverteilung der Residuen, Varianzhomogenität) nicht gegeben sind. Ferner kann ein lineares Regressionsmodell bei einer solchen Variablen zu unzulässigen Vorhersagen führen: Wenn man die beiden Ausprägungen der abhängigen Variablen mit 0 und 1 kodiert, so kann man zwar die Vorhersage eines linearen Regressionsmodells als Vorhersage der Wahrscheinlichkeit auffassen, dass die abhängige Variable den Wert 1 annimmt – formal: P(Yi = 1) –, doch kann es dazu kommen, dass Werte außerhalb dieses Bereichs vorhergesagt werden. Die logistische Regression löst dieses Problem durch eine geeignete Transformation der abhängigen Variablen P(Yi = 1).

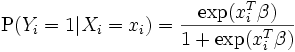

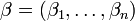

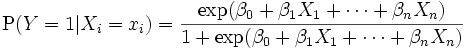

Das logistische Regressionsmodell lautet

,

,

hierbei gilt

.

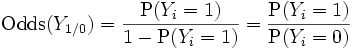

.Es geht aus von der Idee der Odds, d. h. dem Verhältnis von P(Yi = 1) zur Gegenwahrscheinlichkeit 1 − P(Yi = 1) bzw. P(Yi = 0) (bei Kodierung der Alternativkategorie mit 0)

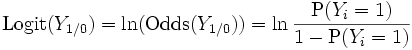

Die Odds können zwar Werte größer 1 annehmen, doch ist ihr Wertebereich nach unten beschränkt (er nähert sich asymptotisch 0 an). Ein unbeschränkter Wertebereich wird durch die Transformation der Odds in die sog. Logits

erzielt; diese können Werte zwischen minus und plus unendlich annehmen.

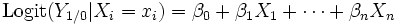

In der logistischen Regression wird dann die Regressionsgleichung

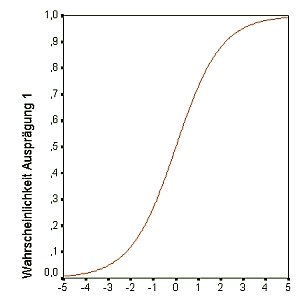

geschätzt; es werden also Regressionsgewichte bestimmt, nach denen die geschätzten Logits für eine gegebene Matrix von unabhängigen Variablen X berechnet werden können. Die folgende Graphik zeigt, wie Logits (X-Achse) mit den Ausgangswahrscheinlichkeiten P(Yi = 1) (Y-Achse) zusammenhängen:

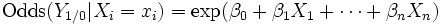

Die Regressionkoeffizienten der logistischen Regression sind nicht einfach zu interpretieren. Daher bildet man häufig die sog. Effektkoeffizienten durch Bildung des Antilogarithmus; die Regressionsgleichung bezieht sich dadurch auf die Odds:

Die Koeffizienten exp(βn) werden oft auch als Effektkoeffizienten bezeichnet. Hier bezeichnen Koeffizienten kleiner 1 einen negativen Einfluss auf die Odds, ein positiver Einfluss ist gegeben, wenn exp(βn) > 1.

Durch eine weitere Transformation lassen sich die Einflüsse der logistischen Regression auch als Einflüsse auf die Wahrscheinlichkeiten P(Yi = 1) ausdrücken:

Die Regressionsparameter werden auf der Grundlage des Maximum Likelihood-Verfahrens geschätzt. Inferenzstatistische Verfahren stehen sowohl für die einzelnen Regressionskoeffizienten als auch für das Gesamtmodell zur Verfügung (siehe Wald-Test und Likelihood-Quotienten-Test); in Analogie zum linearen Regressionsmodell wurden auch Verfahren der Regressionsdiagnostik entwickelt, anhand derer einzelne Fälle mit übergroßem Einfluss auf das Ergebnis der Modellschätzung identifiziert werden können. Schließlich gibt es auch einige Vorschläge zur Berechnung einer Größe, die in Analogie zum R2 der linearen Regression eine Abschätzung der "erklärten Varianz" erlaubt; man spricht hier von sog. Pseudo-R². Auch das AIC und das BIC werden in diesem Kontext gelegentlich herangezogen.

Als (im wesentlichen gleichwertige) Alternative kann das Probitmodell herangezogen werden, bei dem eine Normalverteilung zugrunde gelegt wird.

Eine Übertragung der logistischen Regression (und des Probit-Modells) auf abhängige Variable mit mehr als zwei (nominal- oder ordinalskalierten) Merkmalen ist möglich (siehe Multinomiales Logit und Ordinales Logit.)

Literatur

- Volker Oppitz: Gabler Lexikon Wirtschaftlichkeitsberechnung, Gabler-Verlag 1995, 629 S., ISBN 3409199519

- Hans-Jürgen Andreß, J.-A. Hagenaars, Steffen Kühnel: Analyse von Tabellen und kategorialen Daten Springer Berlin 1997, ISBN 3540625151

- Dieter Urban: Logit Analyse, Lucius & Lucius Stuttgart 1998, ISBN 3828243061

- David Hosmer, Stanley Lemeshow: Applied logistic regression, Wiley New York 2. Auflage 2000, ISBN 0471356328

- Alan Agresti: Categorical Data Analysis, Wiley New York 2. Auflage 2002, ISBN 0471360937

- Volker Oppitz/Volker Nollau: Taschenbuch Wirtschaftlichkeitsrechnung, Carl Hanser Verlag 2003, 400 S., ISBN 3446224637

Weblinks

Wikimedia Foundation.