- Verbundentropie

-

Die Übertragung von Symbolfolgen oder Zeichenketten aus einem endlichen Alphabet ergeben sich in fast allen gängigen wissenschaftlichen Disziplinen, d. h. alle geschriebenen Texte, Programm-Code, DNA-Sequenzen, digital gewandelte Daten von Musik oder Bildern bei der Informationsübertragung sowie eine große Anzahl von Anwendungen aus der Mathematik oder Physik.

Wird eine solche Symbolfolge in aufeinanderfolgende Teilblöcke, Worte oder Subsequenzen aufgeteilt, so kann man diese Teilblöcke formal als Nachricht auffassen. Bei dieser Aufteilung wird im Allgemeinen keine Rücksicht auf syntaktische, semantische oder sonstige Strukturen genommen. Beispielsweise ist das erste Wort der Länge 10 in dieser Einleitung "Die Übertr", das zweite Wort gleicher Länge ist "agung von ".

Jedem dieser unterschiedlichen Teilblöcke entspricht eine Wahrscheinlichkeit, mit welcher dieser in der jeweils vorliegenden Stichprobe auftritt. Die Blockentropie ist definiert als die Entropie, welche den Wahrscheinlichkeiten der Teilblöcke entspricht.

Inhaltsverzeichnis

Blockentropien

Für eine formale Beschreibung der Blockentropien im Rahmen der Theorie von Shannon[1][2] betrachtet man eine unendliche Folge

von Symbolen (Buchstaben, Zeichen) aus einem endlichen Alphabet {0,1,...,d − 1} der Mächtigkeit d. Es wird dabei vorausgesetzt, dass diese Symbole Realisierungen eines stochastischen Prozesses

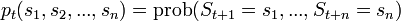

von Symbolen (Buchstaben, Zeichen) aus einem endlichen Alphabet {0,1,...,d − 1} der Mächtigkeit d. Es wird dabei vorausgesetzt, dass diese Symbole Realisierungen eines stochastischen Prozesses  sind mit den Wahrscheinlichkeiten

sind mit den Wahrscheinlichkeiten  für das Auftreten des Teilstrings

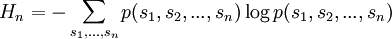

für das Auftreten des Teilstrings  . Üblicherweise werden diese Wahrscheinlichkeiten als stationär angenommen, und man lässt in solchen Fällen den Zeitindex t weg. Die sogenannten Blockentropien der Ordnung n werden von Shannon formal durch

. Üblicherweise werden diese Wahrscheinlichkeiten als stationär angenommen, und man lässt in solchen Fällen den Zeitindex t weg. Die sogenannten Blockentropien der Ordnung n werden von Shannon formal durchdefiniert. Im Rahmen der Kommunikationstheorie von Shannon ist Hn gleich der mittleren Anzahl von Fragen die mindestens benötigt werden um bei binären Antworten den Teilblock s1,...,sn zu erfahren. Dabei wird unterstellt, dass dem Fragenden die Werte für die Wahrscheinlichkeiten der Teilblöcke bekannt sind und das die Fragestrategie auf optimale Weise vorgenommen wird (vgl. Huffman-Kodierung). In diesem Sinne spricht man auch von mittlerer Kodierungslänge der Teilblöcke.

Entropie einer Informationsquelle

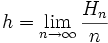

Betrachtet man die Definition der Blockentropie, so stellt sich in diesem Zusammenhang die Frage nach dem Grenzwert, wenn man die Blocklänge der Teilworte formal gegen unendlich streben lässt. Für Quellen, deren Wahrscheinlichkeiten sich nicht im Laufe der Zeit ändern (stationäre Quellen) kann allgemein bewiesen werden, dass der folgende Grenzwert existiert[3]

.

.

Diese Zahl ist die mittlere Kodierungslänge pro Symbol oder auch Shannon-Entropie der Informationsquelle.[2]

Differentielle Entropie

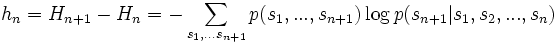

Eine alternative Bestimmung von h, welche ebenfalls auf der Blockentropie basiert, ist durch die differentiellen Entropien

,

,

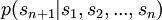

gegeben. Sie geben die mittleren Informationsgehalt des (n + 1)-ten Symbols an, unter der Voraussetzung, dass die vorhergehenden n Symbole

jeweils bekannt sind. Hierbei sind

jeweils bekannt sind. Hierbei sind  die Wahrscheinlichkeiten dafür, dass

die Wahrscheinlichkeiten dafür, dass  eintritt, gegeben dass die vorhergehenden Symbole

eintritt, gegeben dass die vorhergehenden Symbole  vorliegen.

vorliegen.Konvergenzverhalten

Die Folgen hn und Hn / n streben jeweils monoton fallend gegen den Grenzwert h, d.h. sie sind obere Schranke der Entropie der Nachrichtenquelle. Genaue Aussagen über das Konvergenzverhalten dieser Folgen können im Allgemeinen nur für sehr spezielle Systeme (Quellen) bewiesen werden.

Beispiele

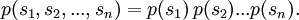

1. Bernoulli-Prozesse: Für sog. Bernoulli-Prozesse faktorisieren die Wahrscheinlichkeiten, d.h.

Somit ist die Blockentropie n-ter Ordnung das n-fache von H1, d.h. Hn = nH1 und der Grenzwert h = H1 ist bereits für n = 1 erreicht.

2. Markov-Prozesse: Bei einer speziellen Form von Nachrichtenquellen mit Gedächtnis, d.h. Markov-Quellen mit der Ordnung m, wächst die Blockentropie gemäß

- Hn = Hm + (n − m)(Hm + 1 − Hm)

für

an. Die Entropie der Markov-Quelle ist demnach h = Hm + 1 − Hm.

an. Die Entropie der Markov-Quelle ist demnach h = Hm + 1 − Hm.3. Für periodische Symbolfolgen mit der Periodenlänge q ergeben weitere Symbole keine neue Information. In diesem Fall ist

- Hn = Hq,

für

. Daher verschwindet die Entropie, d.h. h = 0, - die Nachrichten sind vollständig determiniert.

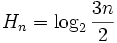

. Daher verschwindet die Entropie, d.h. h = 0, - die Nachrichten sind vollständig determiniert.4. Chaotische Prozesse: Nicht trivial ist beispielsweise die Konvergenz der Blockentropie beim Übergang von periodischem Verhalten zu chaotischem Verhalten in nichtlinearen dynamischen Systemen. Bei der Logistischen Abbildung tritt ein solcher Übergang am sogenannten Feigenbaumpunkt ein. Aufgrund der Struktur der Periodenverdopplung an diesem Punkt ergibt sich für die Blockentropie der Ausdruck

für alle n = 2k und k = 1,2,..., d.h. die Entropie pro Symbol konvergiert

gegen Null.[4] Die differentielle Entropie konvergiert demnach

gegen Null.[4] Die differentielle Entropie konvergiert demnach  gegen Null. Weitere Beispiele für derartiges Konvergenzverhalten ergibt sich beispielsweise für die sog. Rabbit-Sequenz, deren Symboldynamik mit der Kreis-Abbildung im Zusammenhang steht.[5]

gegen Null. Weitere Beispiele für derartiges Konvergenzverhalten ergibt sich beispielsweise für die sog. Rabbit-Sequenz, deren Symboldynamik mit der Kreis-Abbildung im Zusammenhang steht.[5]Statistische Schätzung der Blockentropie

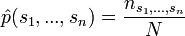

Zur numerischen Schätzung der Entropie aus endlichen Stichproben von Symbolfolgen der Länge N werden gewöhnlich die Wahrscheinlichkeiten

für eine feste Blocklänge n durch den Likelihood-Schätzer

für eine feste Blocklänge n durch den Likelihood-Schätzerbestimmt. Die Häufigkeiten

geben an, wie oft das Wort

geben an, wie oft das Wort  in der Stichbrobe vorkommt. Der Schätzwert

in der Stichbrobe vorkommt. Der Schätzwert  für die Blockentropie Hn wird dann durch einsetzen der relativen Häufigkeiten vorgenommen. Schließlich erhält man einen Entropieschätzer für h durch die Grenzwertbildung

für die Blockentropie Hn wird dann durch einsetzen der relativen Häufigkeiten vorgenommen. Schließlich erhält man einen Entropieschätzer für h durch die Grenzwertbildung  . In numerischen Berechnungen, wenn die der Stichprobe nicht hinreichend umfangreich ist, dann wird eine zuverlässige Schätzung der Wahrscheinlichkeiten

. In numerischen Berechnungen, wenn die der Stichprobe nicht hinreichend umfangreich ist, dann wird eine zuverlässige Schätzung der Wahrscheinlichkeiten  nur sehr schwer möglich. Das kommt daher, dass die Anzahl der möglichen Blöcke mit der Länge n exponentiell zunimmt und damit auch die notwendige Größe N der Stichprobe, die zu einer hinreichend zuverlässigen Bestimmung der Wahrscheinlichkeiten

nur sehr schwer möglich. Das kommt daher, dass die Anzahl der möglichen Blöcke mit der Länge n exponentiell zunimmt und damit auch die notwendige Größe N der Stichprobe, die zu einer hinreichend zuverlässigen Bestimmung der Wahrscheinlichkeiten  benötigt wird. Die Bestimmung der Entropie für endliche Stichproben wird in der Theorie der Entropieschätzung untersucht.[6][7][8][9][10]

benötigt wird. Die Bestimmung der Entropie für endliche Stichproben wird in der Theorie der Entropieschätzung untersucht.[6][7][8][9][10]Referenzen

- ↑ C. E. Shannon, Bell Syst. Tech. 27 (1948) 379.

- ↑ a b C. E. Shannon and W. Weaver, 1949 The Mathematical Theory of Communication (Urbana, IL: University of Illinois Press.)

- ↑ A. I. Khinchin, 1957 Mathematical Foundations of Informationtheory (Dover, 1957).

- ↑ P. Grassberger, Int. J. Theor. Phys. 25 (1986) 907.

- ↑ T. Gramss, Phys. Ref. E 50 (1994) 2612.

- ↑ B. Harris, 1975 The statistical estimation of entropy in the non-parametric case, Topics in Information Theory, ed. Csiszar (Amsterdam: North-Holland) pp. 323-55.

- ↑ H. Herzel, Syst. Anal. Modelling Simul. 5 (1988) 435.

- ↑ P. Grassberger, Phys. Lett.A 128 (1988) 369

- ↑ T. Schürmann und P. Grassberger, CHAOS 6 (1996) 414-427. Online

- ↑ L. Paninski, Neural Comput. 15 (2003) 1191

Siehe auch

Weblinks

- Entropy Rate of a Source (englisch)

- Selbstorganisation und Information, Frank Schweitzer, Institut für Physik der Humboldt-Universität Berlin (pdf)

Wikimedia Foundation.