- Superrechner

-

Ein Supercomputer oder Superrechner ist ein Hochleistungsrechner, der zum Zeitpunkt seiner Einführung im obersten realisierbaren Leistungsbereich arbeitet. Dabei ist es unerheblich, auf welcher Bauweise die Rechner beruhen. Ein typisches Merkmal eines modernen Supercomputers ist seine große Anzahl an Prozessoren, die auf gemeinsame Peripheriegeräte und einen teilweise gemeinsamen Hauptspeicher zugreifen können.

Da sich nicht beliebig schnelle Prozessoren bauen lassen, sind alle Hochleistungsrechner Parallelrechner. Ein Parallelrechner ist ein Computer, in dem Operationen gleichzeitig auf mehrere CPUs verteilt werden, um die Arbeitsgeschwindigkeit zu erhöhen. Für die optimale Nutzung eines Supercomputers muss die Programmierung deshalb möglichst genau auf die einzelnen, parallel arbeitenden Prozessoren abgestimmt werden.

Supercomputer werden heute zumeist als Vektorrechner oder Skalarrechner konzipiert. Sie basieren auf unterschiedlichen Prozessorarchitekturen. Vektorprozessoren (auch Vektorrechner oder Array-Prozessoren genannt) führen eine Berechnung gleichzeitig auf vielen Daten (in einem Vektor bzw. Array) aus. Skalarprozessoren können dagegen nur ein Operandenpaar pro Befehl bearbeiten. Skalarrechner basieren daher oft auf Tausenden von Standardprozessoren, die miteinander vernetzt sind (Computercluster).

Ursprünglich wurde die herausragende Rechenleistung durch maximale Ausnutzung der verfügbaren Technik erzielt, indem Konstruktionen gewählt wurden, die für größere Serienproduktion zu teuer waren (z.B. Flüssigkeitskühlung, exotische Bauelemente und Materialien, kompakter Aufbau für kurze Signalwege), die Zahl der Prozessoren war eher gering. Seit geraumer Zeit etablieren sich vermehrt so genannte Cluster, bei denen eine große Anzahl von (meist preiswerten) Einzelrechnern zu einem großen Rechner vernetzt werden. Im Vergleich zu einem Vektorrechner besitzen die Knoten in einem Cluster eigene Peripherie und ausschließlich einen eigenen, lokalen Hauptspeicher. Cluster verwenden Standardkomponenten, deshalb bieten sie zunächst Kostenvorteile gegenüber Vektorrechnern. Sie erfordern aber einen weit höheren Programmieraufwand. Es ist abzuwägen, ob die eingesetzten Programme sich dafür eignen, auf viele Prozessoren verteilt zu werden. Verwendete Programmiersprachen sind unter anderem Fortran und C.

Eng verbunden mit dem Begriff Supercomputer ist die Firma Cray. Sie ist benannt nach ihrem Gründer Seymour Cray und stellte die ersten Supercomputer in den 1970er Jahren her. Der erste offiziell installierte Supercomputer Cray-1 schaffte 1976 130 MegaFLOPS. (Zum Vergleich: ein normaler PC kann heutzutage mehrere GigaFLOPS ausführen.)

Die schnellsten Supercomputer nach Leistung werden halbjährlich in der Top-500 Liste aufgeführt. Als Bewertungsgrundlage dient der Linpack-Benchmark.

Die schnellsten Supercomputer auch nach Energieeffizienz bzw. MFLOPS/W werden seit November 2007 in der Green500 Liste geführt. Hierbei führen derzeit Server mit Blue-Gene/P-Chips die Liste an, bei denen ein einziger Blue-Gene/P-Chip über jeweils vier niederfrequente (850 MHz) PowerPC-450-Prozessoren verfügt. [1]

Inhaltsverzeichnis

Einsatzzweck von Supercomputern

Die Herstellungskosten eines Supercomputers aus der TOP10 bewegen sich derzeit in einem sehr hohen zweistelligen, oftmals bereits dreistelligen Euro-Millionenbetrag. Nach oben sind dabei keine Grenzen gesetzt. Für den in Planung stehenden neuen Supercomputer im Bereich um 10 PFLOPS werden derzeit fast 700 Millionen Euro veranschlagt. Bei diesen enormen Investitionssummen stellt sich zwangsläufig die Frage, wofür diese sehr teuren Geräte benötigt werden und ob sich die Investition in die Entwicklung eines solchen Gerätes, außer aus reinen Prestigegründen, rentiert.

Die heutigen Supercomputer werden überwiegend zu Simulationszwecken eingesetzt. Je realitätsnäher eine Simulation komplexer Zusammenhänge wird, desto mehr Rechenleistung wird in der Regel benötigt. Der Vorteil der Supercomputer ist außerdem, dass sie durch ihre extrem schnelle und große Rechenleistung immer mehr Interdependenzen berücksichtigen können. Dies erlaubt also das Einbeziehen immer weiterreichender, oftmals auch unscheinbarer Neben- oder Randbedingungen zur eigentlichen Simulation und gewährleistet dadurch ein immer aussagekräftigeres Gesamtergebnis.

Die derzeitigen Haupteinsatzgebiete der Supercomputer umfassen dabei die Bereiche Biologie, Chemie, Geologie, Luft- und Raumfahrt, Medizin, Wetter- sowie Klimaforschung, Militär und Physik.

Bis auf das Militär, welches hauptsächlich militärische Planspiele betreibt, kennzeichnen sich die Bereiche dadurch, dass es sich um sehr komplexe Systeme bzw. Teilsysteme handelt, die in weitreichendem Maße miteinander verknüpft sind. So haben Veränderungen in dem einen Teilsystem meist mehr oder minder starke Auswirkungen auf benachbarte oder angeschlossene Systeme. Durch den Einsatz von Supercomputern wird es immer leichter möglich, viele solcher Konsequenzen zu berücksichtigen oder sogar zu prognostizieren, wodurch bereits weit im Vorfeld etwaige Gegenmaßnahmen getroffen werden könnten. Dies gilt z.B. bei Simulationen zum Klimawandel, der Vorhersagen von Erdbeben oder Vulkanausbrüchen sowie in der Medizin bei der Simulation neuer Wirkstoffe auf den Organismus. (Jedoch sind logischerweise solche Simulationen nur so genau, wie es die programmierten Parameter bzw. Modelle zur Berechnung zulassen.) Die enormen Investitionsummen in die stetige Steigerung der FLOPS und damit die Entwicklung von immer schnelleren Supercomputern werden vor allem mit den Nutzenvorteilen und dem eventuellen „Wissensvorsprung“ für die Menschheit gerechtfertigt, weniger aus den Aspekten des allgemeinen technischen Fortschritts.

Ausgewählte Supercomputer (weltweit)

Name Standort TeraFLOPS Konfiguration Zweck IBM Roadrunner Los Alamos National Laboratory (New Mexico, USA) 1.105 6.000 AMD Dual-Core-Prozessoren, 13.000 IBM Cell-Prozessoren Physikalische Simulationen (z. B. Atomwaffensimulationen) Cray XT5 (Jaguar) Oak Ridge National Laboratory (Oak Ridge nahe Knoxville, Tennessee, USA) 1.059 37.538 AMD Quad-Core-Prozessoren Entwicklung neuer Energiequellen, Technologien und Materialien BlueGene/L Lawrence Livermore National Laboratory Livermore (USA) 478,2 212.992 PowerPC 440 Prozessoren 700 MHz , 73.728 GB RAM Physikalische Simulationen Blue Gene Watson IBM Thomas J. Watson Research Center (USA) 91,29 40.960 PowerPC 440 Prozessoren Forschungsabteilung von IBM, aber auch Anwendungen aus Wissenschaft und Wirtschaft ASC Purple Lawrence Livermore National Laboratory Livermore (USA) 75,76 12.208 Power5 CPUs, 48.832 GB RAM Physikalische Simulationen (z. B. Atomwaffensimulationen) MareNostrum Universitat Politècnica de Catalunya (Spanien) 63,63 10.240 PowerPC 970MP 2,3 GHz Klima- und Genforschung, Pharmazie Columbia NASA Ames Research Center (Silicon Valley, Kalifornien, USA) 51,87 10.160 Intel Itanium 2 Prozessoren (Madison Kern) Klimamodellierung, astrophysikalische Simulationen Earth Simulator Yokohama Institute for Earth Sciences (Japan) 35,86 5120 500 MHz NEC SX-6 CPUs, 10 TB RAM Klimamodellierung ASCI Q Los Alamos National Laboratory (New Mexico, USA) 13,88 8192 DEC Alpha EV68 CPUs, 12 TB RAM Simulation System X oder alt: Terascale Cluster Virginia Polytechnic Institute and State University (USA) 12,25 1100 Dual 2,3 GHz Apple Xserve G5 (IBM PPC970FX CPU), 4,4 TB RAM Quantenchemie, Simulationen, Nanoelektronik und weitere Albert2 BMW Sauber F1 Team / Hinwil (Schweiz) 12,2 512 CPU Intel Xeon 5160-Prozessoren (DualCore) 1.024 Kerne;2.048 GB RAM Computergestützte Strömungssimulation (CFD) MCR Linux Cluster Lawrence Livermore National Laboratory, Livermore (USA) 7,63 2304 Intel 2,4 GHz Xeon CPUs, 4,6 TB RAM Simulation von Nuklearwaffen Ausgewählte Supercomputer (deutschlandweit)

Name Standort TeraFLOPS Konfiguration Zweck JUGENE Forschungszentrum Jülich 180 65.536 PowerPC 450 Prozessoren 850 MHz Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik HLRN-II (SGI Altix ICE/XE) Zuse-Institut Berlin, Rechenzentrum der Universität Hannover 70,4 5872 Cores Intel Xeon Harpertown 3,0 GHz, 16 TB RAM Physik, Chemie, Umwelt- und Meeresforschung, Ingenieurwissenschaften HLRB II LRZ Garching (Deutschland) 56,52 9.728 CPUs 1,6 GHz Intel Itanium 2 (Montecito Dual Core), 39 TB RAM Naturwissenschaften, Astrophysik und Materialforschung JUBL (Jülicher BlueGene/L) Forschungszentrum Jülich 37,33 16.384 PowerPC440-Prozessoren 700 MHz, 4096 GB RAM Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik HP XC4000 Höchstleistungsrechner-Kompetenzzentrum Baden-Württemberg (hkz-bw), Karlsruhe über 15 AMD Opteron, 12 TB RAM Physikalische Simulationen SGI Altix 4700 TU Dresden 13,1 2048 Cores Intel Itanium II Montecito 1,6 GHz, 6656 GB RAM Naturwissenschaften, Biologie NEC SX8/576M72 Höchstleistungsrechenzentrum Stuttgart (HLRS) 8,92 (nur Vektorteil) 576 CPUs 2 GHz SX-8, 9216 GB RAM Ingenieurwissenschaftliche Anwendungen, Physik, Chemie, Lebenswissenschaften, Nutzung durch Industrie CHiC Cluster (IBM x3455) TU Chemnitz 8,21 2152 Cores aus 1076 Dual-Core 64 bit AMD Opteron 2218 (2600 MHz) Modellierung und numerische Simulation JUMP (IBM pSeries 690-Knoten) Forschungszentrum Jülich 5,57 1312 CPUs 1,7 GHz Power4+, 5000 GB RAM Materialwissenschaften, theoretische Chemie, Elementarteilchenphysik, Umwelt, Astrophysik IBM eSeries p5 575-Knoten Max-Planck-Gesellschaft MPI/IPP Garching 4,56 688 CPUs 1,7 GHz Power5, 2816 GB RAM Physikalische Simulationen, z. B. die Millennium-Simulation Sun Fire SMP-Cluster Primer RWTH Aachen [1] 3,5 480 Ultra Sparc IV, 1,2 GHz (dual core); 288 Ultra Sparc IV, 1,05 GHz (dual core); 3 TB RAM IBM eSeries p5 575-Knoten Deutscher Wetterdienst 2,75 416 CPUs 1,9 GHz Power5 ARMINIUS Paderborn Center for Parallel Computing, Universität Paderborn 2,56 200 Dual INTEL XEON je 3,2 GHz + 4 GB RAM, 16 Dual AMD Opteron je 2,2 GHz + 8 GB RAM ALiCEnext Bergische Universität Wuppertal 2,08 1024 CPUs 1,8 GHz Opteron Wissenschaftliche Anwendungen HHLR (Hessischer Hochleistungsrechner) Technische Universität Darmstadt 2,05 (siehe Diskussion) 584 CPUs 1,5 – 1,9 GHz Power4 und Power5 Wissenschaftliche Anwendungen Hitachi SR8000-F1/168 LRZ Garching 1,65 1512 CPUs, 1376 GB RAM vektorisierbare Programme, 2006 stillgelegt NEC SX-6 Deutsches Klimarechenzentrum 1,5 192 Vektor-CPUs, 1,5 TB RAM Klimamodellierung Beowulf-Cluster CLIC TU Chemnitz 0,2216 528 Pentium-III-Prozessoren (800 Mhz), 264 GB SDRAM im Wesentlichen Forschung auf dem Gebiet der Physik an der TU-Chemnitz, 2007 stillgelegt Kepler-Cluster Tübingen 0,096 196 Pentium-III-Prozessoren mit 650 MHz, 100 GB RAM Astrophysik und Strömungsmechanik, Entwicklung stabiler numerischer Verfahren Die schnellsten Supercomputer ihrer Zeit

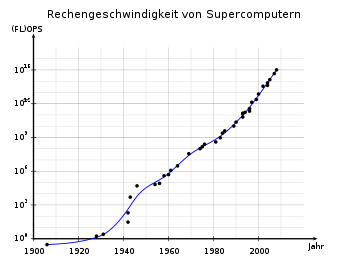

Jahr Supercomputer Spitzengeschwindigkeit Ort 1906 Babbage Analytical Engine, Mill 0,3 OPS RW Munro, Woodford Green, Essex, England 1928 IBM 301[2] 1,7 OPS verschiedene Orte weltweit 1931 IBM Columbia Difference Tabulator[3] 2,5 OPS Columbia University 1942 Atanasoff-Berry Computer (ABC) 30 OPS Iowa State University, Ames (Iowa), USA TRE Heath Robinson 200 OPS Bletchley Park, Milton Keynes, England 1943 Flowers Colossus 5 kOPS 1946

UPenn ENIAC

(vor den Modifikationen von 1948+)50 kOPS Aberdeen Proving Ground, Maryland, USA

1954 IBM NORC 67 kOPS U.S. Naval Proving Ground, Dahlgren, Virginia, USA 1956 MIT TX-0 83 kOPS Massachusetts Inst. of Technology, Lexington, Massachusetts, USA 1958 IBM SAGE 400 kOPS 25 U.S. Air Force-Stützpunkte in den USA und ein Ort in Kanada (52 Computer) 1960 UNIVAC LARC 500 kFLOPS Lawrence Livermore National Laboratory, Kalifornien, USA 1961 IBM 7030 "Stretch" 1,2 MFLOPS Los Alamos National Laboratory, New Mexico, USA 1964 CDC 6600 3 MFLOPS Lawrence Livermore National Laboratory, Kalifornien, USA 1969 CDC 7600 36 MFLOPS 1974 CDC STAR-100 100 MFLOPS 1975 Burroughs ILLIAC IV 150 MFLOPS NASA Ames Research Center, Kalifornien, USA 1976 Cray-1 250 MFLOPS Los Alamos National Laboratory, New Mexico, USA (weltweit über 80 Mal verkauft) 1981 CDC Cyber 205 400 MFLOPS verschiedene Orte weltweit 1983 Cray X-MP/4 941 MFLOPS Los Alamos National Laboratory; Lawrence Livermore National Laboratory; Battelle; Boeing 1984 M-13 2,4 GFLOPS Scientific Research Institute of Computer Complexes, Moskau, UdSSR 1985 Cray-2/8 3,9 GFLOPS Lawrence Livermore National Laboratory, Kalifornien, USA 1989 ETA10-G/8 10,3 GFLOPS Florida State University, Florida, USA 1990 NEC SX-3/44R 23,2 GFLOPS NEC Fuchu Plant, Fuchū, Japan 1993 Thinking Machines CM-5/1024 65,5 GFLOPS Los Alamos National Laboratory; National Security Agency Fujitsu Numerical Wind Tunnel 124,50 GFLOPS National Aerospace Laboratory, Tokio, Japan Intel Paragon XP/S 140 143,40 GFLOPS Sandia National Laboratories, New Mexico, USA 1994 Fujitsu Numerical Wind Tunnel 170,40 GFLOPS National Aerospace Laboratory, Tokio, Japan 1996 Hitachi SR2201/1024 220,4 GFLOPS Universität Tokio, Japan 1996 Hitachi/Tsukuba CP-PACS/2048 368,2 GFLOPS Center for Computational Physics, University of Tsukuba, Tsukuba, Japan 1997 Intel ASCI Red/9152 1,338 TFLOPS Sandia National Laboratories, New Mexico, USA 1999 Intel ASCI Red/9632 2,3796 TFLOPS 2000 IBM ASCI White 7,226 TFLOPS Lawrence Livermore National Laboratory, Kalifornien, USA 2002 NEC Earth Simulator 35,86 TFLOPS Earth Simulator Center, Yokohama-shi, Japan 2004 SGI Project Columbia 42,7 TFLOPS Project Columbia, NASA Advanced Supercomputing Facility, USA IBM BlueGene/L 70,72 TFLOPS U.S. Department of Energy/IBM, USA 2005 IBM BlueGene/L 136,8 TFLOPS U.S. Department of Energy/U.S. National Nuclear Security Administration,

Lawrence Livermore National Laboratory, Kalifornien, USA2008 IBM Roadrunner 1,105 PFLOPS U.S. Department of Energy/U.S. National Nuclear Security Administration,

Los Alamos National Laboratory2009 Cray XT5 (Jaguar) 1,059 PFLOPS Oak Ridge National Laboratory Leistungen von Supercomputern

(im weiteren Sinne)

- zum Vergleich: sämtliche Berechnungen aller Computer weltweit von 1960 bis 1970 könnte der Earth Simulator in etwa 35 Minuten durchführen.

- Deep Blue 2 (Hochleistungsrechner von IBM) schlägt als erster Computer einen Schachweltmeister in einem offiziellen Zweikampf.

- Yasumasa Kanada bestimmt die Kreiszahl Pi mit einem Hitachi SR8000 der Universität Tokio auf 1,24 Billionen Stellen genau.

- Intels Desktop Prozessor Core 2 Quad Q6600 schafft ca. 21,4 GFLOPS und hat damit Supercomputerniveau der frühen 90er Jahre.

- Wenn jeder der rund 6 Milliarden Menschen auf der Welt ein Jahr lang mit einem Taschenrechner in jeder Sekunde eine Rechnung absolvierte, müsste die Menschheit 46 Jahre arbeiten, um das zu erledigen, was der IBM Roadrunner an einem Tag bewältigt.[2]

Quellen

- ↑ The Green 500 List

- ↑ http://www.heise.de/newsticker/Roadrunner-knackt-die-PetaFLOPS-Marke--/meldung/109165

Weblinks

- TOP500 Liste der leistungsstärksten Supercomputer

- TOP500 Liste der energieeffizientesten Supercomputer

- The International Conference for High Performance Computing and Communications

- International Supercomputing Conference in Dresden

- Chemnitz High-Performance Linux Cluster (CHiC)

- Kepler-Cluster an der Universität Tübingen

- CRAY-Seiten des ComputerMuseums München

Wikimedia Foundation.