- Hard disc

-

Speichermedium

Allgemeines Name Hard Disk Drive Abkürzung HDD Typ magnetisch Ursprung Erfindungsjahr 1956 Erfinder IBM Eine Festplatte (englisch hard disk drive = HDD) ist ein magnetisches Speichermedium der Computertechnik, welches binäre Daten auf die Oberfläche einer rotierenden, ferromagnetischen Scheibe schreibt. Dazu wird die hartmagnetische Beschichtung der rotierenden Plattenoberfläche entsprechend der aufzuzeichnenden Information magnetisiert. Durch die Remanenz erfolgt die Speicherung der Information. Das Auslesen der Information erfolgt durch Abtastung der Magnetisierung der Plattenoberfläche mittels des Lesekopfes.

Neuerdings werden mit vergleichbaren Speicherkapazitäten auch Flash-Speicher und Hybridspeicher funktionsgleich als „Festplatten“ angeboten.

Im Gegensatz zu den dünnen, flexiblen (engl. floppy) Scheiben in Disketten bestehen die Scheiben von Festplatten aus starrem Material und werden deshalb als „hard disk“ (fest, nicht entnehmbar) bezeichnet.

Auf einer Festplatte können beliebige Daten gespeichert werden: Sowohl Dateien des Betriebssystems des Computers oder auch andere, etwa durch Anwendungsprogramme erzeugte persönliche Daten, welche dauerhaft gespeichert werden.

In Abgrenzung zu sequentiell adressierbaren Speichermedien wie Magnetband oder Lochstreifen werden Festplatten den direktadressierbaren Speichermedien (engl. direct access storage devices, DASD) zugerechnet, da auf die Daten direkt zugegriffen werden kann (Vergleich: Tonband ↔ Schallplatte).

Inhaltsverzeichnis

Allgemeine technische Daten

Speicherkapazität

Die Speicherkapazität einer Festplatte ist die Gesamtzahl an Bits (0 oder 1), die durch die ansteuernde Software, also meist das Betriebssystem oder vielmehr dessen Gerätetreiber, adressiert werden können. Die Kapazität wird normalerweise in Byte gemessen, 8 Bit bilden 1 Byte. Bei der Aufzeichnung erfolgt durch den gewöhnlich im Festplattengehäuse eingebauten Controller eine weitere Kodierung der Daten, weshalb kein unmittelbarer Zusammenhang zwischen den gespeicherten Daten und der daraus folgenden Magnetisierung der Plattenoberfläche besteht.

Der Übersichtlichkeit halber wird die Anzahl Bits in Kilo-, Mega-, Giga- und Terabit bzw. -byte angegeben. Vor allem Festplattenhersteller definieren bei der Angabe der Kapazität ein Gigabyte mathematisch nach Potenzen zur Basis 10, also als 109 Byte = 10003 Byte = 1.000.000.000 Byte. Dem gegenüber steht die Umrechnung von Computerprogrammen, die auf dem traditionellen System, den Potenzen zur Basis 2, basierte: ein Gigabyte wird hier meist als 230 Byte = 10243 Byte = 1.073.741.824 Byte behandelt. Zur Unterscheidung hat die IEC dafür die Bezeichnung Gibibyte eingeführt, welche sich jedoch nicht durchgesetzt hat. Die daraus resultierenden unterschiedlichen Größenangaben für die Speicherkapazität lassen sich anhand von Binärpräfixen unterscheiden.

Die derzeit (Stand: Anfang 2009) größte Festplatte mit einer Kapazität von 2 Terabyte (2000 GB) ist ein 3,5-Zoll-Modell von Western Digital. Die zeitliche Entwicklung der maximalen Festplattenkapazität zeigt einen annähernd exponentiellen Verlauf, vergleichbar mit der Entwicklung der Rechenleistung nach dem Mooreschen Gesetz. Die Kapazität hat sich etwa alle 5 Jahre verzehnfacht.

Baugrößen

Die physikalische Größe von Festplatten wird traditionell in Zoll angegeben und ist keine exakte Größenangabe, sondern ein Formfaktor. So sind beispielsweise 3,5"-Festplatten exakt 100 mm breit, was knapp 4 Zoll entspricht. Die Größe der Magnetscheiben in der Festplatte beträgt maximal den als Formfaktor angegebenen Wert; bei Serverfestplatten mit sehr hohen Rotationsgeschwindigkeiten auch weniger.

Im Zuge der technischen Weiterentwicklung sind immer wieder Baugrößen zu Gunsten kleinerer eingestellt worden, da diese weniger anfällig gegen Erschütterungen sind und weniger Strom verbrauchen. Die Datendichte entwickelt sich hingegen mit so hoher Geschwindigkeit, dass die verringerte Fläche nur eine kurzzeitige Bremse darstellt.

Die erste Festplatte IBM 350 von 1956 hatte eine Baugröße von 24". Mitte der 1970er kamen Modelle mit einer Größe von 8" auf, die ebenfalls recht schnell durch die wesentlich handlicheren und vor allem leichteren 5,25"-Festplatten abgelöst wurden. Dazwischen gab es noch Größen von 14" und 9".

5,25″-Festplatten wurden 1980 von Seagate eingeführt, jedoch ist diese Gattung seit 1997 ausgestorben. Einige SCSI-Server-Platten sowie die LowCost-ATA-Platte BigFoot von Quantum waren die letzten Vertreter dieser Spezies. Man unterscheidet Geräte mit voller Bauhöhe (3,5″ bzw. ca. 88 mm), die zwei Steckplätze belegen, und halber Bauhöhe (1,75″ bzw. ca. 44 mm). Es gibt aber auch Modelle mit noch geringerer Bauhöhe, so hat die bereits erwähnte BigFoot beispielsweise in der 4-GB-Version eine Bauhöhe von nur 0,75" (etwa 19 mm). Die Breite beträgt 146 mm, die Tiefe ist variabel und sollte nicht wesentlich oberhalb von 200 mm liegen.

3,5"-Festplatten wurden ca. 1990 eingeführt und sind derzeit (2009) Standard in Desktop-Computern. Im Server-Bereich wurden sie inzwischen durch 2,5"-Modelle abgelöst, die effektiv mehr Daten pro Platz unterbringen können und selbst bei höheren Drehzahlen deutlich weniger Strom verbrauchen. Die meisten Platten haben 1" bzw. ca. 25 mm Bauhöhe. Im Serverbereich gibt es auch Platten bis 1,8" Höhe (1,8" bzw. ca. 44 mm). Die Breite beträgt 100 mm, die Tiefe ist variabel und sollte nicht wesentlich oberhalb von 150 mm liegen. Inzwischen ist auch die Zukunft derartiger Festplatten für den Desktop-Markt fraglich.[1]

2,5"-Baugrößen finden schon seit ihrer Einführung Verwendung in Notebooks oder Spezialrechnern. Die traditionelle Bauhöhe war 0,5" (12,7 mm), mittlerweile gibt es mit 0,375" (9,5 mm) und 0,25" (6,35 mm) flachere Festplatten – und auch Notebooks, die diese flachen Varianten benötigen. Die Breite beträgt 68 mm, die Tiefe 100 mm. Der Anschluss ist gegenüber den größeren Bauformen modifiziert, bei ATA wird z. B. ein 44-poliger Anschluss verwendet, der gleichzeitig die Betriebsspannung von +5 Volt zuführt (Pin 1 ist meist auf der Seite der Jumper). Im Gegensatz zu den größeren Platten kommen diese Platten ohne 12-Volt-Betriebsspannung (zusätzlich zu der 5-Volt-Spannung) aus.

Seit 2006 bietet Seagate und im Weiteren auch andere Hersteller zudem auch 2,5"-Festplatten für den Einsatz in Servern an, die weniger Strom verbrauchen, Platz sparen und die Ausfallsicherheit erhöhen sollen. Weitere Hersteller sind Toshiba, Hitachi und Fujitsu. Seit April 2008 wird von Western Digital mit der Velociraptor auch eine 2,5"-Festplatte (allerdings mit 15 mm Bauhöhe) mit 3,5"-Einbaurahmen als Desktop-Festplatte vermarktet.[2]

1,8"-Baugrößen werden seit 2003 bei Sub-Notebooks sowie diversen Industrieanwendungen verwendet. Ebenso in großen MP3-Playern. Hitachi kündigte Ende 2007 an, keine 1,8″-Festplatten mehr herzustellen, da Flash-Speicher diese Baugröße verdränge.[3]

Noch kleinere Baugrößen spielen kaum eine Rolle. Eine der wenigen Ausnahmen sind die sogenannten Microdrives; Festplatten mit einer Baugröße von 1", die vergleichsweise große und günstige CompactFlash-Typ-II-Speichereinheiten für beispielsweise Digitalkameras ermöglichten. Inzwischen wurden diese nahezu vollständig durch günstigeren Flash-Speicher verdrängt, der darüber hinaus auch wesentlich robuster, schneller, leichter, leiser und energiesparender ist. Darüber hinaus gab es 2005 kurzzeitig von der Firma Toshiba Festplatten mit einer Baugröße von nur 0,85" und einer Kapazität von 4 GB (3,73 GiB). Diese Modelle waren nur für Spezialanwendungen gedacht und nur in begrenzten Mengen erhältlich.

Überblick über die Speicherkapazitäten der verschiedenen Baugrößen

Jahr 5,25″ 3,5″ 2,5″ 1,8″ 1,0″ 0,85″ typ. Modell(e) mit hoher Kapazität Quelle 1981 10 MB - - - - - Seagate ST-412 (Aus dem IBM PC XT) 1988 360 MB 20 MB - - - - Maxtor XT-4380E (5,25″) bzw. Fuji FK309-26 1990 676 MB 106 MB - - - - Maxtor XT-8760E (5,25″) bzw. Conner CP3104 1992 2 GB 426 MB 120 MB - - - Digital (DEC) DSP-5200S ('RZ73', 5,25″), Seagate ST1480A (3,5″) bzw. Conner CP2124 (2,5″) 1993 1,06 GB - - - Digital RZ26 (3,5″) 1994 2,1 GB - - - Digital RZ28 (3,5″) 1995 9,1 GB 1,6 GB 422 MB - - - Seagate ST410800N (5,25″ FH), Conner CFS1621A (3,5″) bzw. Conner CFL420A (2,5″) 1997 12 GB 16,8 GB 4,8 GB - - - Quantum Bigfoot (12 GB, 5,25″), Nov. 1997, IBM Deskstar 16GP (3,5″) bzw. Fujitsu MHH2048AT (2,5″) [4] 1998 47 GB - - - Seagate ST446452W (47 GB, 5,25″), 1.Quartal 1998 [5] 2001 # 73 GB 40 GB - 340 MB - Seagate mit 73 GB 2002 # 320 GB - Maxtor MaXLine-Plus-II (320 GB, 3,5″), Ende 2002 [6] 2005 # 500 GB 120 GB 60 GB 8 GB 6 GB Hitachi Deskstar 7K500 (500 GB, 3,5″), Juli 2005 [7] 2006 # 750 GB * 200 GB 80 GB 8 GB # Western Digital WD5000KS, Seagate Barracuda 7200.10 750 GB, u. a. [8] 2007 # 1 TB * 320 GB * 160 GB 8 GB # Hitachi Deskstar 7K1000 (1.000 GB, 3,5″), Januar 2007 [9] 2008 # 1,5 TB * 500 GB * 250 GB 40 GB * # Seagate ST31500341AS (1.500 GB, 3,5″), Juli 2008

Samsung Spinpoint M6 HM500LI (500 GB, 2,5″), Juni 2008

Toshiba MK2529GSG (250 GB, 1,8″), September 2008

LaCie LF (40 GB, 1,0"), Dezember 2008[10]

[11]

[12]

[13]2009 # 2 TB * 500 GB * 250 GB 40 GB * # Western Digital Caviar Green WD20EADS (2.000 GB, 3,5″), Januar 2009 [14] Anmerkungen:

- Die beispielhaften Angaben beziehen sich immer auf die im jeweiligen Jahr größte käuflich erhältliche Festplatte, unabhängig von ihrer Drehzahl oder Schnittstelle.

- Die Festplattenhersteller bedienen sich der SI-Präfixe, d. h. ein Gigabyte ist definiert als 10003 Byte = 109 Byte = 1.000.000.000 Byte, ein Megabyte als 10002 Byte = 106 Byte. Dies hat für die Hersteller unter anderem den Vorteil, dass die Zahlenangaben größer erscheinen.

- * unter Verwendung von Perpendicular Recording

- # Baugröße veraltet; nicht mehr in Gebrauch

Aufbau und Funktion

Physischer Aufbau der Einheit

Eine Festplatte besteht aus folgenden Bauelementen:

- einer oder mehreren drehbar gelagerten Scheiben (auch Platter genannt (eng.: Platters))

- einer Welle, auch Spindel genannt, auf der die Scheiben übereinander montiert sind

- einem Elektromotor als Antrieb für die Scheibe(n)

- bewegliche Schreib-/Leseköpfe (Heads)

- jeweils ein Lager für Platter (meistens hydrodynamische Gleitlager) sowie für die Schreib-/Leseköpfe (auch Magnetlager)

- einem Antrieb für die Schreib-/Leseköpfe

- der Steuerelektronik für Motor- und Kopfsteuerung

- Hochleistungs-DSP für die Schreib/Leseköpfe

- der Schnittstelle zur Verbindung mit dem Festplattencontroller (auf der Hauptplatine)

- einem Festplattencache von derzeit 2 bis 64 MB Größe.

Technischer Aufbau und Material der Scheiben

Die Scheiben bestehen meistens aus oberflächenbehandelten Aluminium-Legierungen, vereinzelt auch aus Glas. Sie müssen formstabil sein und eine geringe elektrische Leitfähigkeit aufweisen, um die Größe der Wirbelströme gering zu halten. Da die magnetisierbare Schicht besonders dünn sein soll, darf das Material der Scheiben selbst jedoch keine magnetischen Eigenschaften besitzen und dient nur als Träger der Magnetschicht. Auf die Scheiben wird eine Eisenoxid- oder Kobaltschicht von ungefähr einem Mikrometer Stärke aufgetragen. Heutige Festplatten werden durch Sputtern von sogenannten "high storage density media" (dt. Material für hohe Speicherdichte) wie CoCrPt hergestellt. Die magnetische Schicht wird zusätzlich mit einer Deckschicht aus diamantähnlichem Kohlenstoff versehen (engl. "carbon overcoat"), um mechanische Beschädigungen zu vermeiden. Die zukünftige Verkleinerung der magnetischen Bits erfordert sowohl die Erforschung von "ultra high storage density media" als auch von alternativen Konzepten, da man sich langsam dem superparamagnetischen Limit nähert. Zusätzlich wurde eine Steigerung der Datendichte durch besseres Trägermaterial sowie durch die Optimierung der Schreibverfahren erreicht.

In älteren Desktopfestplatten von IBM (Deskstar 75GXP/40GV DTLA-30xxxx, Deskstar 60GXP/120GXP IC35Lxxxx) aus den Jahren 2000 bis 2002 kam Glas als Material für die Scheiben zum Einsatz. Neuere Modelle der Festplattensparte von IBM (2003 übernommen durch Hitachi) verwenden jedoch wieder Aluminium, mit Ausnahme der Festplatten für den Serverbereich. In dem Festplattengehäuse befindet sich eine oder mehrere übereinander liegende rotierende Scheiben. Verbaut wurden bisher ein bis zwölf Scheiben, üblich sind ein bis fünf. Eine höhere Scheibenanzahl geht in der Regel mit höherem Energieverbrauch und größerer Geräuschentwicklung einher. Manchmal werden aus Platzgründen oder um ein Modell mit einer geringeren Kapazität anzubieten, ohne extra andere Platten herzustellen, nicht alle Scheibenoberflächen genutzt, so dass Festplatten mit ungerader Schreib-/Lesekopfanzahl entstehen. Um die Nachfrage nach Festplattenmodellen mit kleinerer Kapazität zu befriedigen, können die Hersteller ebenfalls auf diese Weise die Kapazität künstlich beschränken bzw. verkleinern. Eine neuere Entwicklung (seit 2004) ist das Perpendicular Recording, um die Datendichte weiter zu steigern. Seit Erscheinen der ersten 3,5" HD mit dieser Technik im Jahre 2006, der Cheetah 15K.5 von Seagate, wurde die Technik schnell von weiteren großen Herstellern übernommen und ist häufig in den 2008 käuflichen Festplatten implementiert.

Achsen-Lagerung und Drehzahlen (U/min)

In Arbeitsplatzrechnern oder Privat-PCs verwendete Festplatten – momentan zum größten Teil Platten mit ATA-, SATA-, SCSI oder SAS-Schnittstelle – rotieren mit Geschwindigkeiten von 5.400 bis 10.000 Umdrehungen pro Minute. Vor der Zeit der ATA-Festplatten und im Bereich der Hochleistungsrechner und Server wurden bisher überwiegend Festplatten mit den technisch überlegenen SCSI-, FC- oder SAS-Schnittstellen verwendet, die inzwischen in der Regel 10.000 oder 15.000 Umdrehungen pro Minute erreichen. Bei den 2,5-Zoll-Festplatten, die hauptsächlich in Notebooks zum Einsatz kommen, liegen die Spindelgeschwindigkeiten im Bereich von 4.200 bis 7.200 Umdrehungen pro Minute. Die Achsen der Scheiben früherer Festplatten (bis 2000) waren kugelgelagert; heute (2006) werden überwiegend hydrodynamische Gleitlager (engl. „fluid dynamic bearing“ – FDB) verwendet. Diese zeichnen sich durch eine höhere Lebensdauer, geringere Geräuschentwicklung und geringere Herstellungskosten aus.

Die Schreib-Lesekopfeinheit

Der Schreib-/Lesekopf (Magnetkopf) des Schreibfingers, im Prinzip ein winziger Elektromagnet, magnetisiert winzige Bereiche der Scheibenoberfläche unterschiedlich und schreibt somit die Daten auf die Festplatte. Aufgrund eines Luftpolsters, das durch die Reibung der Luft an der rotierenden Scheibenoberfläche erzeugt wird, schweben die Schreib-/Leseköpfe (vgl. Bodeneffekt). Die Schwebehöhe liegt heutzutage (2006) im Bereich von etwa 20 Nanometern, weswegen die Luft innerhalb des Festplattengehäuses keinerlei Verunreinigungen enthalten darf. Bei neuesten Festplatten mit Perpendicular-Recording-Technik schrumpft dieser Abstand auf 10 Nanometer. Der Bodeneffekt ist in diesem Zusammenhang sehr nützlich zur Einhaltung der richtigen Flughöhe des Schreib-/Lesekopfes über der rotierenden Scheibe. Zum Vergleich: Ein Haar ist etwa 0,05 mm = 50 µm = 50.000 nm dick. Die Herstellung von Festplatten erfolgt deshalb wie die von Halbleitern in Reinräumen. Die Daten wurden bis ca. 1994 durch Induktion des Magnetfelds der magnetisierten Fläche in der Spule des Schreib-/Lesekopfes ausgelesen. Über die Jahre wurden jedoch aufgrund der steigenden Datendichte die Flächen, auf denen einzelne Bits gespeichert werden, immer kleiner. Um diese Daten auszulesen, werden kleinere und empfindlichere Leseköpfe benötigt. Diese wurden nach 1994 entwickelt: MR-Leseköpfe sowie einige Jahre später GMR-Leseköpfe (Riesenmagnetowiderstand). Der GMR-Lesekopf ist eine Anwendung der Spintronik.

In der Anfangszeit der Festplatten wurden die Schreib-/Leseköpfe mit Schrittmotoren angesteuert, da die Spurabstände noch groß waren. Bei den zur Zeit üblichen Schreibdichten sorgen Tauchspulsysteme mit Lageregelung für die Positionierung. Bei der Hitachi Deskstar 7K500 beträgt die Anzahl der Spuren pro Zoll (tpi) z. B. 135.000, während die Bitdichte in der Spur (bpi) 872.000 beträgt.

Zum Schutz der Scheiben-Oberflächen vor dem Aufsetzen der Schreib-/Leseköpfe fahren diese, noch bevor sich beim Ausschalten der Festplatte die Umdrehungsgeschwindigkeit merklich verringert hat, in die so genannte „Landezone“ („landing zone“), in der sie fixiert werden. Diese Parkposition kann sich außerhalb der Scheiben befinden oder im Innenbereich der Platten. Dabei setzt der Schreib-/Lesekopf auf einem vordefinierten Bereich der Festplatte auf, der keine Daten enthält. Die Oberfläche dieses Bereichs ist besonders vorbehandelt, um ein Festkleben des Kopfes zu vermeiden und so einen späteren Wiederanlauf der Festplatte zu ermöglichen. Die Fixierung geschieht z. B. über einen kleinen Magneten, der den Lesekopf festhält.

Bei älteren Festplatten wurden die Schreib-/Leseköpfe bei fast allen Modellen aus den Plattenstapel herausgefahren. Später (1990er, 2000er) wurde zunehmend die Parkposition im Innenbereich bevorzugt. Heutzutage (2008) kommen beide Verfahren vor, sowohl bei Notebook-Platten als auch bei Desktop-Platten. Bei Notebook-Platten bietet die Parkposition außerhalb des Plattenstapels zusätzlichen Schutz vor Beschädigung der Oberfläche der Scheiben bei Transport (Erschütterung) der Festplatte.

Bei älteren Festplatten mussten die Köpfe explizit vor dem Ausschalten per Befehl vom Betriebssystem geparkt werden. Das Parken erhöht auch die Stoßfestigkeit der Festplatten für einen Transport oder Umbau. Doch auch moderne Festplatten müssen mitunter explizit geparkt werden, da der beschriebene automatische Parkmechanismus nach Wegfall der Versorgungsspannung zu einem erhöhten Verschleiß führen kann.[15] Heutzutage wird dieser Befehl automatisch beim Herunterfahren des Systems vom Gerätetreiber abgesetzt.

Bei modernen Laptops sorgt ein Beschleunigungssensor für das Parken des Festplattenfingers noch während eines eventuellen freien Falls, um so den Schaden beim Sturz eines Rechners zu begrenzen.

Festplatten-Gehäuse

Das Gehäuse einer Festplatte ist sehr massiv, es ist meist ein aus einer Aluminiumlegierung bestehendes Gussteil und mit einem Edelstahl-Blechdeckel versehen.

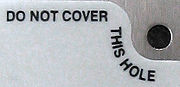

Es ist staub-, aber nicht luftdicht abgeschlossen: Durch eine mit einem Filter versehene kleine Öffnung kann bei Temperaturänderungen oder anders verursachten Luftdruckschwankungen Luft ein- oder austreten, um so die Druckunterschiede auszugleichen. (Diese Öffnung – siehe nebenstehende Abbildung – darf nicht verschlossen werden, vor allem wegen der Wärmeausdehnung der im Plattengehäuse vorhandenen Luft.) Da der Luftdruck im Gehäuse mit zunehmender Höhe über dem Meeresspiegel abnimmt, zum Betrieb aber ein Mindestdruck erforderlich ist, durften diese Festplatten nur bis zu einer bestimmten, maximalen Höhe betrieben werden. Diese ist in der Regel im zugehörigen Datenblatt vermerkt. Die Luft ist erforderlich, um die direkte Berührung von Lesekopf und Festplatte zu verhindern, siehe oben bei Die Schreib-Lesekopfeinheit.

Bei neueren Laufwerken wurde der Filter durch eine elastische Membran ersetzt, die das System durch Aufwölben in die eine oder andere Richtung an wechselnde Druckverhältnisse anpassen kann.

Wird eine Festplatte in normaler, verunreinigter Luft geöffnet, sorgen bereits kleinste Staub-/Rauchpartikel, Fingerabdrücke etc. für wahrscheinlich irreparable Beschädigungen der Plattenoberfläche und der Schreib-/Leseköpfe.

Speichern (Schreiben) und Lesen der Daten

Das Speichern der Daten auf einer Festplatte erfolgt durch die gezielte Magnetisierung kleinster – vom Schreibfinger angesteuerter – Flächen der permeablen Schicht ferromagnetischen Materials, die entsprechend ihrer Polarität (Nord/Süd) den elektronisch-binär interpretierten Wert 0 oder 1 annehmen. Beim Lesen der jeweiligen Sequenzen von 0- und 1-Werten werden die Informationen dekodiert und an das Betriebssystem übergeben. Sie werden vom Prozessor des Computers ausgewertet und weiterverarbeitet. Entsprechend umgekehrt geht das Schreiben der vorher vom Prozessor erstellten Daten vonstatten.

Vor dem Schreiben werden die Daten mittels spezieller Verfahren, wie den früher üblichen GCR, MFM, RLL und heute üblichen PRML oder EPRML, kodiert. Ein Bit der Anwenderdaten entspricht daher physikalisch nicht unmittelbar einem magnetischen Flusswechsel auf der Plattenoberfläche. Die Kodierung muss der Festplattencontroller vornehmen, zusammen mit dem Verwalten der Daten (Organisation der Daten in Blöcke) und dem Führen des Schreib-/Lesekopfes über die Spuren.

Sowohl beim Schreiben als auch beim Lesen muss vor dem Zugriff auf einen bestimmten Block der Schreib-/Lesekopf der Platte bewegt und anschließend abgewartet werden, bis durch die Rotation der Platte dieser Block unter dem Kopf vorbeigeführt wird. Diese mechanisch bedingten Verzögerungen liegen heutzutage bei ca. 5–10 ms, was nach Maßstäben anderer Computerhardware eine kleine Ewigkeit ist. Daraus ergibt sich die extrem hohe Latenzzeit von Festplatten im Vergleich zu RAM, die noch auf der Ebene der Softwareentwicklung und der Algorithmik berücksichtigt werden muss.

Um eine hohe Leistung zu erreichen, muss eine Festplatte, soweit möglich, immer große Mengen von Daten in aufeinander folgenden Blöcken lesen oder schreiben, weil dabei der Schreib-/Lesekopf nicht neu positioniert werden muss.

Dies wird unter anderem dadurch erreicht, dass möglichst viele Operationen im RAM durchgeführt und auf der Platte die Positionierung der Daten auf die Zugriffsmuster abgestimmt werden. Dazu dient vor allem ein großer Cache als Teil der Festplattenelektronik, auf dessen Inhalt mit RAM-Geschwindigkeit zugegriffen werden kann. Die Firmware der Festplatte sorgt für die korrekte Verwaltung und Aktualisierung des Cache-Inhalts. Zusätzlich zum Hardware-Cache gibt es in allen modernen Betriebssystemen noch einen Disk Cache oder VCache genannten Cache im Arbeitsspeicher.

Neben der Verwendung eines Caches gibt es weitere Software-Strategien zur Performance-Steigerung. Sie werden vor allem in Multitasking-Systemen wirksam, wo das Festplattensystem mit mehreren bzw. vielen Lese- und Schreibanforderungen gleichzeitig konfrontiert wird. Es ist dann meist effizienter, diese Anforderungen in eine sinnvolle neue Reihenfolge zu bringen. Die Steuerung erfolgt durch einen Festplatten-Scheduler. Das einfachste Prinzip hierbei verfolgt dabei dieselbe Strategie wie eine Fahrstuhlsteuerung: Die Spuren werden zunächst in einer Richtung angefahren und die Anforderungen beispielsweise nach monoton steigenden Spurnummern abgearbeitet. Erst wenn diese alle abgearbeitet sind, kehrt die Bewegung um und arbeitet dann in Richtung monoton fallender Spurnummern usw.

Auf einer tieferen Ebene optimierte man früher den Datenzugriff durch Interleaving, was bei modernen Festplatten aber nicht mehr notwendig ist.

Logischer Aufbau der Scheiben

Die Magnetisierung der Beschichtung der Scheiben ist der eigentliche Informationsträger. Sie wird vom Schreib/Lesekopf auf kreisförmigen, konzentrischen Spuren aufgebracht, während die Scheibe rotiert. Eine Scheibe enthält typischerweise einige tausend solcher Spuren, meist auch auf beiden Seiten. Die Gesamtheit aller gleichen, d. h. übereinander befindlichen, Spuren der einzelnen Platten(oberflächen) nennt man Zylinder. Jede Spur ist in kleine logische Einheiten unterteilt, die man Blöcke nennt. Ein typischer Block enthält 512 Byte an Nutzdaten (Anwenderdaten). Jeder Block verfügt dabei über Kontrollinformationen (Prüfsummen), über die sichergestellt wird, dass die Information auch korrekt geschrieben oder gelesen wurde. Die Gesamtheit aller Blöcke, die die gleichen Winkelkoordinaten auf den Platten haben, nennt man Sektor. Der Aufbau eines speziellen Festplattentyps, das heißt, die Anzahl der Spuren, Oberflächen und Sektoren, wird auch als Festplattengeometrie bezeichnet. Verwirrenderweise wird der Begriff Sektor häufig fälschlicherweise auch synonym für Block verwendet.

Da manche Betriebssysteme zu früh an Grenzen stießen, als die Nummerierung der Blöcke bei steigenden Festplattenkapazitäten die Wortgrenze (16 Bit) überstieg, führte man Cluster ein. Das sind Gruppen von jeweils einer festen Anzahl an Blöcken (z. B. 32), die sinnvollerweise physisch benachbart sind. Das Betriebssystem spricht dann nicht mehr einzelne Blöcke an, sondern verwendet auf seiner (höheren) Ebene diese Cluster als kleinste Zuordnungseinheit. Erst auf Hardwaretreiber-Ebene wird dieser Zusammenhang aufgelöst.

Bei modernen Festplatten ist normalerweise die wahre Geometrie, also die Anzahl an Sektoren, Köpfen und Zylindern, die vom Festplatten-Controller verwaltet werden, nach außen (d. h. für den Computer bzw. den Festplattentreiber) nicht sichtbar. Der Computer, der die Festplatte benutzt, arbeitet dann mit einer virtuellen Festplatte, die völlig andere Geometriedaten aufweist. Dies erklärt, warum zum Beispiel eine Festplatte, die real nur vier Köpfe aufweist, vom Computer mit 255 Köpfen gesehen wird. Ein Grund für dieses virtuelle Konzept ist, dass man Begrenzungen von PC-kompatibler Hardware überwinden wollte. Weiterhin kann der Festplatten-Controller dadurch defekte Blöcke ausblenden, um dann einen Block aus einem Reserve-Bereich einzublenden. Für den Computer sieht es immer so aus, als wären alle Blöcke defektfrei und nutzbar. Es wird vermutet, dass besagter Reserve-Bereich bzw. Reserve-Spuren ca. 10–20 % des auf der Festplatte angegebenen Speicherplatzes ausmachen. Dieser Speicherplatz lässt sich durch spezielle Firmware-Varianten nutzen, was dann aber logischerweise die Lebensdauer der Festplatte (bzw. die Datensicherheit) reduziert. Heute übliche Festplatten teilen weiterhin die Platten in Zonen auf, wobei eine Zone mehrere Spuren mit jeweils der gleichen Anzahl an Blöcken enthält.

Partitionen als Laufwerke

Aus Sicht des Betriebssystems können Festplatten durch Partitionierung in mehrere Bereiche unterteilt werden. Das sind keine echten Laufwerke, sondern werden vom Betriebssystem als solche dargestellt. Man kann sie sich als virtuelle Festplatten vorstellen, die durch den Festplattentreiber dem Betriebssystem gegenüber als getrennte Geräte dargestellt werden. Abgesehen von zeitlichen Effekten sowie dem Verhalten im Falle des Festplattenausfalls ist nicht erkennbar, ob es sich um eine physikalisch getrennte Festplatte oder lediglich um ein logisches Laufwerk handelt.

Jede Partition wird vom Betriebssystem gewöhnlich mit einem Dateisystem formatiert. Unter Umständen werden, je nach benutztem Dateisystem, mehrere Blöcke zu Clustern zusammengefasst, die dann die kleinste logische Einheit für Daten sind, die auf die Platte geschrieben werden. Das Dateisystem sorgt dafür, dass Daten in Form von Dateien auf die Platte abgelegt werden können. Ein Inhaltsverzeichnis im Dateisystem sorgt dafür, dass Dateien wiedergefunden werden und hierarchisch organisiert abgelegt werden können. Der Dateisystem-Treiber verwaltet die belegten, verfügbaren und defekten Cluster. Ein Beispiel für ein Dateisystem ist das (von MS-DOS und Windows 9x ausschließlich unterstützte) FAT-Dateisystem.

Lärmvermeidung

Um die Lautstärke der Laufwerke beim Zugriff auf Daten zu verringern, unterstützen die meisten für den Desktop-Einsatz gedachten ATA- und SATA-Festplatten „Automatic Acoustic Management“ (AAM). Wird die Festplatte in einem leisen Modus betrieben, werden die Schreib/Leseköpfe weniger stark beschleunigt, so dass die Zugriffe leiser sind. Das Laufgeräusch des Plattenstapels sowie die Daten-Transferrate wird davon nicht verändert, jedoch verlängert sich die Zugriffszeit.

Schnittstellen, Bussystem und Jumperung

Als Schnittstelle der Festplatte zum Computer wird heute im Desktop-Bereich hauptsächlich die serielle SATA (oder S-ATA)-Schnittstelle eingesetzt. Bis vor kurzem war hier noch die parallele ATA (oder IDE, EIDE)-Schnittstelle üblich. Bei professionellen Servern und Workstations sind SCSI (parallel), Fibre-Channel und SAS (beide seriell) üblich.

Ältere, heute nicht mehr erhältliche, Schnittstellen sind ST506 (mit den Modulationsstandards MFM, RLL und ARLL) und ESDI.

Die Mainboards waren lange Zeit mit meist zwei ATA-Schnittstellen versehen, inzwischen - teilweise zusätzlich, teilweise stattdessen - mit bis zu 10 SATA-Schnittstellen.

Ein vergleichbarer Wandel ist im Bereich der Server bzw. Speicher-Subsysteme zu erkennen. Neben den noch oft verwendeten SCSI-Festplatten werden mehr und mehr serielle Typen wie Fibre-Channel- oder SAS-Festplatten eingesetzt.

Ein prinzipielles Problem bei parallelen Übertragungen ist, dass es mit zunehmender Geschwindigkeit immer schwieriger wird, unterschiedliche Laufzeiten der einzelnen Bits durch das Kabel zu korrigieren. Daher stoßen die parallelen Schnittstellen mittlerweile an ihre Grenzen; diese Einschränkung fällt bei seriellen Übertragungstechniken weg, womit höhere Übertragungsraten möglich werden.

ATA (IDE)

Bei einer ATA-Festplatte wird durch Jumper festgelegt, ob sie das Laufwerk mit Adresse 0 oder 1 der ATA-Schnittstelle ist (Device 0 bzw. 1, oft auch mit Master bzw. Slave bezeichnet). Manche Modelle erlauben auch eine Beschränkung der an das Betriebssystem bzw. BIOS gemeldeten Kapazität des Laufwerks, wodurch die Festplatte im Falle von Inkompatibilitäten dennoch (unter Verschenkung des nicht gemeldeten Plattenplatzes) in Betrieb genommen werden kann.

Durch die Festlegung der ATA-Bus-Adresse können zwei Festplatten an einer ATA-Schnittstelle des Mainboards angeschlossen werden. Die meisten Mainboards haben zwei ATA-Schnittstellen, genannt primary ATA und secondary ATA, also „erste“ und „zweite ATA-Schnittstelle“. Daher können insgesamt bis zu vier Festplatten an beide ATA-Schnittstellen der Hauptplatine angeschlossen werden. Ältere BIOS von Hauptplatinen erlauben es nur, den Computer von der ersten ATA-Schnittstelle zu starten, und auch nur, wenn die Festplatte als Master gejumpert ist.

Die ATA-Schnittstellen werden jedoch nicht nur von Festplatten, sondern auch von CD-ROM- und DVD-Laufwerken genutzt. Somit ist (ohne Zusatzkarte) die Gesamtzahl von Festplatten plus ladbaren Laufwerken (CD-ROM, DVD) auf vier begrenzt (Diskettenlaufwerke haben eine andere Schnittstelle). Es gibt sogar Adapter, mit denen Compact-Flash-Karten angeschlossen und wie eine Festplatte verwendet werden können.

Bei Erweiterungen sind einige Dinge zu beachten:

- Das erste Laufwerk ist als „Master“ zu jumpern – in der Regel die Voreinstellung von Laufwerken; erst ein eventuell zweites Laufwerk an einem Kabel wird auf „Slave“ gejumpert. Einige Laufwerke haben noch die dritte Option „Single Drive“. Diese wird dann benutzt, wenn das Laufwerk alleine am Kabel hängt; kommt ein „Slave“-Laufwerk dazu, muss man das erste als „Master“ jumpern. Diese Option heißt dann zur Erläuterung oftmals „Master with Slave present“.

- Wo Master oder Slave sitzen (am Ende des Kabels oder „mittendrin“), spielt keine Rolle (außer, beide Laufwerke sind auf Cable Select gejumpert). „Slave allein“ funktioniert zwar meistens, gilt aber nicht als sauber konfiguriert und ist oft störanfällig. Ausnahme: Bei den neueren 80-poligen Kabeln sollte der Slave in der Mitte angeschlossen werden; die Stecker sind dementsprechend beschriftet.

Die ideale Verteilung der Laufwerke auf die einzelnen Anschlüsse ist disputabel. Zu beachten ist, dass sich traditionell zwei Geräte am selben Kabel die Geschwindigkeit teilen und dass stets das langsamste unterstützte Busprotokoll verwendet wird. Das gilt jedoch nicht mehr für moderne Controller/Mainboards. Außerdem dauert das Kopieren von Daten zwischen den Platten sehr viel länger, wenn beide Festplatten am selben Kabel hängen. Neben den Jumpern existiert ein automatischer Modus für die Bestimmung der Adressen („Cable-Select“), der aber in der Praxis kaum Verwendung findet.

SCSI

SCSI-Festplatten kennen nicht nur zwei, sondern, je nach verwendetem Controller, acht oder sechzehn Adressen. Daher finden sich an älteren SCSI-Laufwerken drei oder vier Jumper zur Bestimmung der Adressen – ID-Nummern genannt –, die es erlauben, bis zu sieben bzw. 15 Geräte zu adressieren (der Controller belegt eine eigene Adresse). Alternativ erfolgt die Adresseinstellung auch durch einen kleinen Drehschalter. Bei modernen Systemen werden die IDs automatisch vergeben (nach der Reihenfolge am Kabel), und die Jumper sind nur noch relevant, wenn diese Vergabe beeinflusst werden soll.

Dazu kommen noch andere Jumper wie der (optionale) Schreibschutzjumper, der es erlaubt, eine Festplatte gegen Beschreiben zu sperren. Weiterhin können je nach Modell Einschaltverzögerungen oder das Startverhalten beeinflusst werden.

SATA

→ Hauptartikel: Serial ATA

Seit 2002 werden Festplatten zusätzlich mit einer Serial ATA (S-ATA oder SATA)-Schnittstelle angeboten. Die Vorteile gegenüber ATA sind der höhere mögliche Datendurchsatz und die vereinfachte Kabelführung. Erweiterte Versionen von SATA verfügen über weitere, vor allem für professionelle Anwendungen relevante, Funktionen, wie etwa die Fähigkeit zum Austausch von Datenträgern im laufenden Betrieb (Hot-Plug). Inzwischen hat sich SATA praktisch durchgesetzt, die neuesten Festplatten werden nicht mehr als IDE-Versionen angeboten, seit die bei IDE theoretisch möglichen Transferraten nahezu erreicht sind.

Im Jahr 2005 wurden erste Festplatten mit Serial Attached SCSI (SAS) als potentieller Nachfolger von SCSI für den Server- und Storagebereich vorgestellt. Dieser Standard ist teilweise zu SATA abwärtskompatibel.

Serial Attached SCSI

Die SAS-Technik basiert auf der etablierten SCSI-Technik, sendet die Daten jedoch seriell. Neben der höheren Geschwindigkeit im Vergleich zu herkömmlicher SCSI-Technik können theoretisch über 16.000 Geräte in einem Verbund angesprochen werden. Ein weiterer Vorteil ist die maximale Kabellänge von 10 Metern. Die Steckverbindungen von SATA sind zu SAS kompatibel, ebenso SATA-Festplatten; SAS-Festplatten benötigen jedoch einen SAS-Controller.

Fibre-Channel-Interface

Die Kommunikation via Fibre-Channel-Interface ist noch leistungsfähiger und ursprünglich vor allem für die Verwendung in Speichersubsystemen entwickelt. Die Festplatten werden, wie bei USB, nicht direkt angesprochen, sondern über einen FC-Controller, FC-HUBs oder FC-Switches.

Queuing im SCSI-, SATA oder SAS-Datentransfer

Vor allem bei SCSI-Platten und auch bei neueren SATA-Festplatten werden sogenannte Queues (Warteschlangen) eingesetzt. Dies sind Software-Verfahren als Teil der Firmware, die die Daten zwischen dem Anfordern von Computerseite und physikalischem Zugriff auf die Speicherscheibe verwalten und ggf. zwischenspeichern. Beim Queuing reihen sie die Anfragen an den Datenträger in eine Liste und sortieren sie entsprechend der physikalischen Position auf der Scheibe und der aktuellen Position der Schreibköpfe, um so möglichst viele Daten mit möglichst wenigen Umdrehungen und Kopfpositionierungen zu lesen. Der festplatteneigene Cache spielt hierbei eine große Rolle, da die Queues in diesem abgelegt werden (siehe auch: Tagged Command Queuing, Native Command Queuing).

Vorläufer der seriellen High-Speed-Schnittstellen

Die ersten verbreiteten seriellen Schnittstellen für Festplatten waren SSA (Serial Storage Architecture, von IBM entwickelt) und Fibre-Channel in der Variante FC-AL (Fibre Channel-Arbitrated Loop). SSA-Festplatten werden heute praktisch nicht mehr hergestellt, aber Fibre-Channel-Festplatten werden weiterhin für den Einsatz in großen Speichersystemen gebaut. Fibre Channel bezeichnet dabei das verwendete Protokoll, nicht das Übertragungsmedium. Deshalb haben diese Festplatten trotz ihres Namens keine optische, sondern eine elektrische Schnittstelle.

Externe Festplatten

Es werden universelle Schnittstellen wie FireWire oder USB, seltener auch eSATA, für den Anschluss von externen Festplatten verwendet. Hierbei sind jedoch die eingebauten Festplatten selbst mit herkömmlichen (meist ATA- oder SATA-)Schnittstellen ausgestattet. Die Signale werden mittels eines speziellen Wandlers im externen Gehäuse in FireWire- bzw. USB-Signale übersetzt und über die FireWire- bzw. USB-Schnittstelle nach außen geführt. Eine reine USB-Festplatte, das heißt mit eigener USB-Schnittstelle, wird von keinem Hersteller angeboten.

Bei derartigen „externen Festplatten“ sind teilweise zwei Festplatten in einem Gehäuse verbaut, die nach außen jedoch nur als ein Laufwerk auftreten (RAID-System). Sehr ähnlich arbeiten NAS-Systeme, bei denen dann ein Netzwerkanschluss vorhanden ist. Hierbei ist die Kapazität praktisch unbegrenzt erweiterbar.

Datensicherheit

Ausfallrisiken und Lebensdauer

Zu den typischen Ausfallrisiken gehören:

- Die Anfälligkeit von Festplatten ist besonders bei den neuen, sehr schnell drehenden Systemen vorwiegend auf thermische Probleme zurückzuführen.

- Beim mechanischen Aufsetzen des Schreib-Lesekopfes kann die Festplatte beschädigt werden (Head-Crash). Der Kopf schwebt im Betrieb über der Platte und wird nur durch ein Luftpolster am Aufsetzen gehindert, das durch die von der drehenden Scheibe mitgerissene Luft entsteht. Im laufenden Betrieb sollte die Festplatte daher möglichst nicht bewegt werden und keinen Erschütterungen ausgesetzt sein.

- Äußere Magnetfelder können die Sektorierung der Festplatte irreversibel zerstören. Eine Löschung mit einem Magnetfeld macht neuere Festplatten unbrauchbar.

- Fehler in der Steuerelektronik oder Verschleiß der Mechanik führen zu Ausfällen.

- Umgekehrt kann auch längerer Stillstand dazu führen, dass die Mechanik in Schmierstoffen stecken bleibt und die Platte gar nicht erst anläuft („sticky disk“). Dieses Problem trat akut in den 1990er Jahren auf, scheint seitdem aber durch bessere Schmierstoffe einigermaßen im Griff zu sein.

Die durchschnittliche Zahl an Betriebsstunden, bevor eine Festplatte ausfällt, wird bei irreparablen Platten als MTTF (Mean Time To Failure) bezeichnet. Bei Festplatten, die repariert werden können, wird ein MTBF-Wert (Mean Time Between Failures) angegeben. Alle Angaben zur Haltbarkeit sind ausschließlich statistische Werte. Die Lebensdauer einer Festplatte kann daher nicht im Einzelfall vorhergesagt werden, denn diese hängt von vielen Faktoren ab:

- Vibrationen und Stöße: Starke Erschütterungen können zu einem vorzeitigen (Lager-)Verschleiß führen und sollten daher vermieden werden.

- Unterschiede zwischen verschiedenen Modellreihen eines Herstellers: Abhängig vom jeweiligen Modell lassen sich bestimmte Baureihen ausmachen, die als besonders zuverlässig oder fehleranfällig gelten. Um statistisch genau Angaben zu der Zuverlässigkeit machen zu können, sind allerdings eine große Anzahl von baugleichen Platten notwendig, die unter ähnlichen Bedingungen betrieben werden. Systemadministratoren, die viele Systeme betreuen, können so im Laufe der Jahre durchaus einige Erfahrungen sammeln, welche Festplatten eher zu auffälligem Verhalten und damit vorzeitigem Ausfall neigen.

- Anzahl der Zugriffe (Lesekopfbewegungen): Durch häufige Zugriffe verschleißt die Mechanik schneller, als wenn die Platte nicht genutzt wird und sich nur der Plattenstapel dreht.

- Wenn die Festplatte über der von Hersteller genannten Betriebstemperatur, meist 40–55 °C, betrieben wird, leidet die Lebensdauer. Nach einer Studie von Google (die ihre internen Festplattenausfälle analysiert haben) gibt es auch am oberen Ende des zulässigen Bereiches keine vermehrten Ausfälle.

Allgemein sind schnelldrehende Server-Festplatten für eine höhere MTTF ausgelegt als typische Desktop-Festplatten, so dass sie theoretisch eine höhere Lebensdauer erwarten lassen. Dauerbetrieb und häufige Zugriffe können jedoch dazu führen, dass sich dies relativiert und die Festplatten nach wenigen Jahren ausgetauscht werden müssen.

Notebook-Festplatten werden durch die häufigen Transporte besonders beansprucht und sind dementsprechend trotz robusterer Bauart mit einer kleineren MTTF als Desktop-Festplatten spezifiziert.

Eine genaue Haltbarkeit der gespeicherten Daten wird von den Herstellern nicht angegeben. Sie dürfte sich aber wie auch bei Magnetbändern im Bereich von etwa 10 bis 30 Jahren bewegen, da magnetische Umwelteinflüsse (schon ein leicht oszillierendes Magnetfeld der Erde) zu einer Entmagnetisierung führen. Lediglich magneto-optische Verfahren erreichen 50 Jahre und mehr.

Vorbeugende Maßnahmen

Als vorbeugende Maßnahmen gegen Datenverlust werden daher häufig folgende Maßnahmen ergriffen:

- Von wichtigen Daten sollte immer eine Sicherungskopie (Backup) auf einem anderen Datenträger (beachte den Hinweis zum Ausfall oben unter Partionierung) existieren.

- Systeme, die zwingend hochverfügbar sein müssen und bei denen ein Festplattenfehler keine Betriebsunterbrechung und Datenverlust verursachen darf, verfügen meistens über RAID. Eine Konfiguration ist zum Beispiel das Mirrorset (RAID 1), bei dem die Daten auf zwei Festplatten gespiegelt werden und sich somit die Ausfallsicherheit erhöht. Effizientere Konfigurationen sind RAID 5 und höher. Ein Stripeset (RAID 0) aus zwei Festplatten erhöht zwar die Geschwindigkeit, jedoch steigt auch das Ausfallrisiko. RAID 0 ist deshalb keine Maßnahme, um Datenverlust zu verhindern oder die Verfügbarkeit des Systems zu erhöhen.

- ATA-Festplatten verfügen seit ca. Ende der 1990er Jahre über S.M.A.R.T., eine interne Überwachung der Festplatte auf Zuverlässigkeit. Der Status kann von außen abgefragt werden. Ein Nachteil ist, dass S.M.A.R.T. kein Standard ist. Jeder Hersteller definiert seine Fehlertoleranz selbst, d. h. S.M.A.R.T. ist nur als allgemeines Richtmittel anzusehen. Außerdem gibt es Festplatten, deren S.M.A.R.T.-Funktion selbst dann noch nicht vor Problemen warnt, wenn diese sich bereits im Betrieb durch nicht mehr lesbare Blöcke bemerkbar gemacht haben.

- Um durch Überhitzung der Festplatte bedingte Ausfälle zu verhindern, muss diese entsprechend ihrer maximal erlaubten Betriebstemperatur (in der Regel 40–55 °C) gekühlt werden. In Servern kommen dazu mit Lüftern versehene Wechselrahmen und Backplanes zum Einsatz. Bei Desktop-Festplatten ist hingehen eine eigene Kühlung meist unnötig.

Datenschutz

Unabhängig vom verwendeten Speichermedium (in diesem Fall eine Festplatte) wird beim Löschen einer Datei lediglich im Dateisystem vermerkt, dass der entsprechende Datenbereich nun frei ist. Die Daten selbst verbleiben jedoch physisch auf der Festplatte, bis der entsprechende Bereich mit neuen Daten überschrieben wird. Mit Datenrettungsprogrammen können gelöschte Daten daher oft zumindest zum Teil wiederhergestellt werden. Das wird auch häufig in der Beweissicherung zum Beispiel bei den Ermittlungsbehörden (Polizei etc.) eingesetzt.

Beim Partitionieren oder gewöhnlichen Formatieren wird der Datenbereich nicht überschrieben, sondern lediglich die Partitionstabelle oder die Beschreibungsstruktur des Dateisystems. Bei einer Low-Level-Formatierung dagegen wird der gesamte adressierbare Bereich einer Festplatte überschrieben.

Um ein sicheres Löschen von sensiblen Daten zu garantieren, bieten verschiedene Hersteller Software an, sogenannte Eraser, die beim Löschen den Datenbereich überschreibt. Meistens kann aber auf eine (fast) beliebige und kostenlose Unix-Distribution zurückgegriffen werden, wie zum Beispiel Knoppix oder FreeSBIE, die praktischerweise direkt von CD gestartet werden kann. Außerdem gibt es für diesen Zweck neben universellen Programmen wie dd und badblocks speziell für das Löschen verschiedene Opensource-Programme, beispielsweise Darik's Boot and Nuke (DBAN). In Apples MacOS X sind entsprechende Funktionen („Papierkorb sicher löschen“ und „Volume mit Nullen überschreiben“) bereits enthalten. Wurde die Datei bereits gelöscht, ohne die Daten zu überschreiben, kann auch der komplette freie Speicher der Festplatte überschrieben werden. Siehe dazu auch Gutmann-Methode (dabei wird der Speicher mehrmals überschrieben, um zu verhindern, dass sich die Daten mit Spezialhardware z. B. von Datenrettungsunternehmen oder Behörden wiederherstellen lassen).

Alternativ bietet sich bei der Verschrottung des Computers die mechanische Vernichtung der veralteten Festplatte (bzw. der Scheiben) an. Deshalb werden in manchen Unternehmen beim Umstieg auf eine neue Computergeneration alle Festplatten in einem Schredder in kleine Teile zermahlen und die Daten so vernichtet.

Verschiedene Festplatten bieten die Möglichkeit an, den kompletten Festplatteninhalt per Passwort direkt auf Hardwareebene zu schützen. Da diese im Grunde nützliche Eigenschaft jedoch kaum bekannt ist und die meisten BIOS die Funktion zum Setzen des Passworts nicht selbsttätig ausschalten, besteht rein theoretisch für Schadprogramme wie Viren die Chance, dem Benutzer durch Setzen dieses Passworts auf einen unbekannten Wert massiv zu schaden. Danach bestünde keine Möglichkeit mehr, noch auf Inhalte der Festplatte zuzugreifen. Für weitere Informationen bzgl. ATA-Festplatten siehe Passwortschutz unter ATA.

Langzeitarchivierung

Die Archivierung digitaler Informationen über längere Zeiträume (10 bis mehrere hundert Jahre) wirft Probleme auf, da nicht nur die Informationen evtl. verloren gegangen sind, sondern weil auch die Computer, Betriebssysteme und Programme zum Bereitstellen dieser Informationen nicht mehr verfügbar sind. Ansonsten sind die Daten in sich ständig wiederholenden Zyklen neu zu archivieren.

Nur analoge Verfahren, wie Mikrofilm oder Druck auf spezielles Papier, bieten zur Zeit die Möglichkeit, auch über sehr lange Zeiträume auf Informationen zugreifen zu können.

Siehe dazu auch: Bestandserhaltung.

Geschichte

Vorläufer der Festplatte war die Magnettrommel ab 1932. Außerhalb von Universitäten und Forschungseinrichtungen kam dieser Speicher ab 1958 als „Hauptspeicher“ mit 8192 Worten à 32 Bit in der Zuse Z22 zum Einsatz. Die erste kommerziell erhältliche Festplatte, die IBM 350, wurde von IBM 1956 als Teil des IBM 305 RAMAC-Rechners („Random Access Method of Accounting and Control“) angekündigt.

Chronologische Übersicht

- September 1956[16]: IBM stellt das erste magnetische Festplattenlaufwerk mit der Bezeichnung „IBM 350“ vor (5 MB, 24 Zoll, 600 ms Zugriffszeit, 1200 rpm, 500 kg, 10 kW). Die Schreib-/Leseköpfe wurden elektronisch-pneumatisch gesteuert, weshalb die schrankgroße Einheit auch einen Druckluft-Kompressor enthielt.[17] Das Laufwerk wurde nicht verkauft, sondern für ca. 10.000 DM pro Monat an Unternehmen vermietet. Ein Exemplar der IBM350 befindet sich im Museum des IBM-Clubs in Sindelfingen.

- 1973: IBM startet das „Winchester“-Projekt, das sich damit befasste, einen rotierenden Speicher mit einem fest montierten Medium zu entwickeln (IBM 3340, 30 MB Speicherkapazität, 30 ms Zugriffszeit). Beim Starten und Stoppen des Mediums sollten die Köpfe auf dem Medium aufliegen, was einen Lademechanismus überflüssig machte. Namensgeber war die Stadt Winchester in Südengland, in deren IBM-Werk das Laufwerk entwickelt wurde. Diese Technik setzte sich in den folgenden Jahren durch. Bis in die 1990er Jahre war deshalb für Festplatten die Bezeichnung Winchester-Laufwerk gebräuchlich.

- 1979: Vorstellung der ersten 8″-Winchester-Laufwerke. Diese waren jedoch sehr schwer und teuer (ca. 1000 Euro/MB); trotzdem stieg der Absatz kontinuierlich.

- 1980: Verkauf der ersten 5,25″-Winchester-Laufwerke durch die Firma Seagate Technology („ST506“, 6 MB, 3600 rpm, Verkaufspreis ca. 1000 $). Diese Modellbezeichnung (ST506) wurde auch über viele Jahre hinaus der Name für diese neue angewendete Schnittstelle, welche alle anderen Firmen als neuen Standard im PC-Bereich übernommen hatten. Zur gleichen Zeit kam neben den bereits bestehenden Apple-Microcomputern der erste PC von IBM auf den Markt, dadurch stieg die Nachfrage nach diesen – im Vergleich zu den Winchester-Laufwerken kompakten – Festplatten rasant an.

- 1986: Spezifikation von SCSI, eines der ersten standardisierten Protokolle für eine Festplattenschnittstelle.

- 1989: Standardisierung von IDE, auch bekannt als AT-Bus.

- 1991: erste 2,5-Zoll Festplatte mit 100 MB Speicherkapazität [18]

- 1997: Erster Einsatz des Riesen-Magnetowiderstands (englisch Giant Magnetoresistive Effect (GMR)) bei Festplatten, dadurch konnte die Speicherkapazität stark gesteigert werden. Eine der ersten Festplatten mit GMR-Leseköpfen brachte IBM im November 1997 heraus (IBM Deskstar 16GP DTTA-351680, 3,5″, 16,8 GB, 0,93 kg, 9,5 ms, 5400 rpm).

- 2004: Erste SATA-Festplatten mit Native Command Queuing von Seagate.

- 2005: Prototyp einer 2,5-Zoll-Hybrid-Festplatte (Kurzbezeichnung H-HDD), die aus einem magnetisch-mechanischen Teil und einem zusätzlichen NAND-Flash-Speicher aufgebaut ist, der als Puffer für die Daten dient. Erst wenn der Puffer voll ist, werden die Daten aus dem Puffer auf das Magnetmedium der Festplatte geschrieben.

- 2006: Erste 2,5-Zoll Notebook-Festplatte („Momentus 5400.3“, 2,5″, 160 GB, 0,1 kg, 5,6 ms, 5400 rpm, 2 Watt) von Seagate mit senkrechter Aufzeichnungstechnik (Perpendicular Recording). 3,5-Zoll-Festplatten erreichen mit derselben Aufzeichnungstechnik im April eine Kapazität von 750 GB.

- 2007: Die erste Terabyte-Festplatte von Hitachi.[19] (3,5″, 1 TB, 0,7 kg, 8,5 ms, 7200 rpm, 11 Watt)

Hersteller

Name Marktanteile Q2-2007 Seagate 34,0 % Western Digital 21,6 % Hitachi GST 17.0 % Samsung 11,9 % Toshiba 7,0 % Fujitsu 6,4 % ExcelStor 1,6 % Top-7 Anbieter weltweit, Marktanteil nach Stückzahlen [20]

Siehe auch

- Diskettenlaufwerk

- Filecard

- Umdrehungsgeschwindigkeiten von Laufwerken

- Master Boot Record

- Kategorie:Festplatten-Hersteller

Quellen

- ↑ http://www.computerbase.de/news/hardware/laufwerke/massenspeicher/2008/juni/nur_25-zoll-hdds_seagate/

- ↑ [1]

- ↑ heise online – Hitachi will keine Mini-Festplatten mehr produzieren

- ↑ heise online – Billige IDE-Platten bis 12 GByte

- ↑ [2]

- ↑ [3]

- ↑ heise online – Festplatten speichern ein halbes Terabyte Daten

- ↑ heise online – Notebook-Festplatte mit 160 GByte und Perpendicular Recording

- ↑ Hitachi kündigt Festplatte mit 1 TByte Kapazität an – PCtipp.ch – News

- ↑ http://www.golem.de/showhigh2.php?file=/0807/60995.html

- ↑ http://www.channelpartner.de/tests/hardware-tests/festplatten/262072/

- ↑ Toshiba: Schnelle Festplatte im 1,8-Zoll-Format

- ↑ [4]

- ↑ http://www.computerbase.de/news/hardware/laufwerke/massenspeicher/2009/januar/2-tb-hdd_western_digital/

- ↑ Kap. 11.4.2 „Emergency unload“, Hard Disk Drive Specification Hitachi Travelstar 80GN

- ↑ Je nach Quelle 04.09.1956, 13.09.1956 oder 14.09.1956

- ↑ IBM Archives: IBM 350 disk storage unit

- ↑ Facts and History

- ↑ [http://www.hitachigst.com/portal/site/en/template.MAXIMIZE/menuitem.368c8bfe833dee8056fb11f0aac4f0a0/ ? javax.portlet.tpst=74ef8e8d695bcd876ccf7be1cf4362b4_ws_MX&javax.portlet.prp_74ef8e8d695bcd876ccf7be1cf4362b4_viewID=content&javax.portlet.prp_74ef8e8d695bcd876ccf7be1cf4362b4_docName=20070105_first_terabyte_hd.html&javax.portlet.prp_74ef8e8d695bcd876ccf7be1cf4362b4_folderPath=%2Fhgst%2Faboutus%2Fpress%2Finternal_news%2F&beanID=804390503&viewID=content&javax.portlet.begCacheTok=token&javax.portlet.endCacheTok=token] Pressemitteilung von Hitachi

- ↑ http://www.heise.de/resale/Festplattenhersteller-duerfen-auf-versoehnliches-Jahresendgeschaeft-hoffen--/news/meldung/98749

Weblinks

Wikimedia Foundation.

.jpg)

.jpg)